毎週金曜日午後掲載

本レポートに掲載した銘柄:エヌビディア(NVDA、NASDAQ)、スーパー・マイクロ・コンピューター(SMCI、NASDAQ)

エヌビディア

1.エヌビディアの「GTC2024」が開幕

エヌビディアの年次テクノロジー・カンファレンス「GTC2024」が、2024年3月18日(現地時間)に開幕しました。3月21日(現地時間)までアメリカ・サンノゼにおいて開催されます。

今回は、エヌビディアのジェイスン・ファンCEOの基調講演のテーマである新型AI半導体「Blackwell(ブラックウェル)」の中身を見ていきたいと思います。

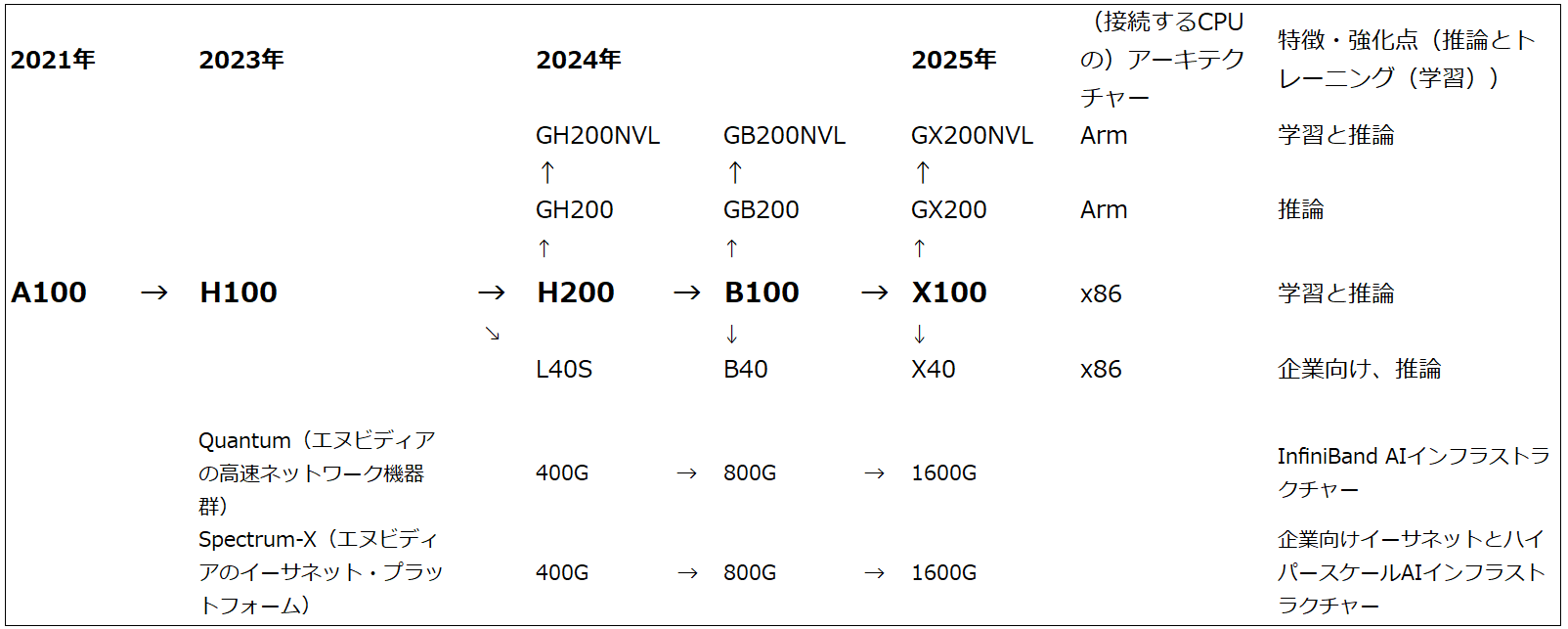

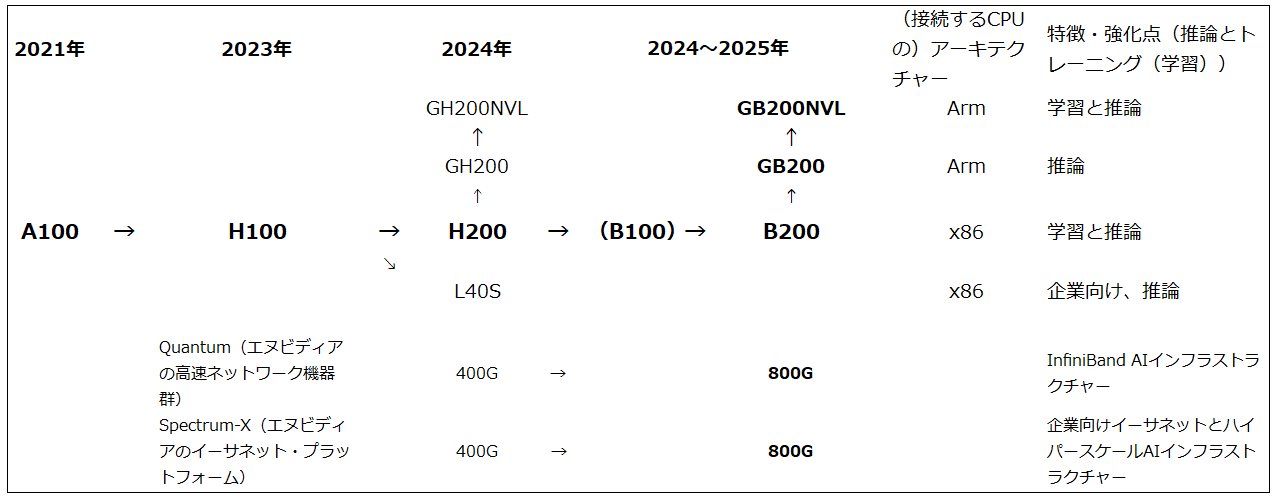

まず、3月18日に開催されたファンCEOの基調講演では、現行アーキテクチャー「Hopper」による今の主力AI半導体「H100」、その拡張版「H200」、「H200」の上位機種「GH200」の次世代機として、新アーキテクチャー「Blackwell(ブラックウェル)」を使った「B200」「GB200」「GB200NVL72」が紹介されました。「B200」は2023年10月にエヌビディアが公開した投資家向け資料の中で発表されたロードマップの中にはない製品ですが、「H100」「H200」の次世代機の位置付けになると思われます。「Blackwell GPU」のダイ(「ダイ」はチップのこと)を2つ連結して1つのパッケージにしたものです。

その上位機種が「GB200」でエヌビディアのサーバー用高性能CPU「Grace」と「B200」を合体させたものです。「GB200」は1個の「Grace」ダイと2個の「Blackwell GPU」ダイを接続して一つのパッケージにしたものです。さらに「GB200」をエヌビディアの高速接続技術「NVLink」によって高速化したものが、「GB200NVL」になります。

基調講演の中では、「B200」「GB200」と後述の「GB200NVL72」に説明が集中しており、「B100」についての説明はほぼありませんでしたが、「B100」も出荷される見込みです。

図1 エヌビディアのAI用GPUロードマップ(2023年10月)

図2 エヌビディアのAI用GPUロードマップ(「GTC2024」基調講演を踏まえた楽天証券による修正後)

注:GTC2024のエヌビディアCEOによる基調講演では、「X100」に対するコメントがなかったため、2025年の「X100」系統の部分を省いた。

2.「GB200」の性能

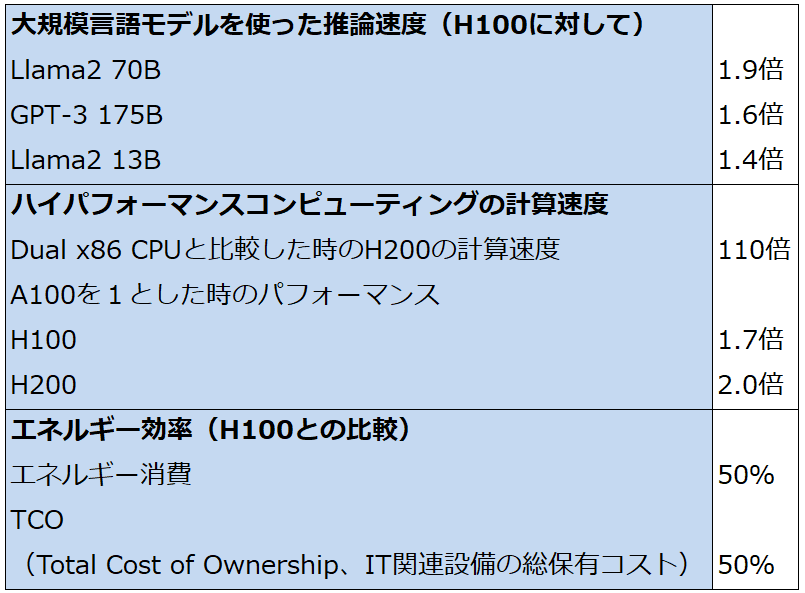

基調講演の中で「GB200」と「H100」の性能比較が示されました。MoE(Mixture of Experts:特定のタスクに特化した複数のexpertを入力に対して切り替えることで性能を上げる機械学習の手法)1.5テラのGPTを90日間トレーニング(機械学習)する場合、「H100」を使う場合は8,000個の「H100」で15MW(メガワット)の電力が必要になります。これが「GB200NVL72」(36 個の「Grace」と72個の「Blackwell GPU」、即ち36個の「GB200」を一つのラックの中で連結したもの)を複数台使う場合は、2,000個の「Blackwell GPU」で4MWの電力で済みます。大幅な電力消費の低減が実現できます。

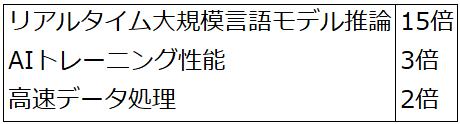

また、ファンCEOの基調講演の中で示されたグラフによれば、「H100」と「GB200」を比較すると推論性能は最大30倍高くなります。

「H100」と「B200」の比較では、エヌビディアが公表した資料によれば、表2のようになります。推論性能は15倍、AIトレーニング性能は3倍となります。

「B200」は192GBのHBM3e(DRAMの最新規格「DDR5」をベースにした特殊メモリの最新型)を装備します。「GB200」は384GBのHBM3eを装備します。「H100」の80GB(HBM2e)、「H200」の141GB(HBM3e)と比べて、GPUメモリの容量が拡大します。また、「B200」「GB200」のメモリ帯域幅は8TB/s(毎秒8テラバイト)であり、「H100」の2TB/s、「H200」の4.8TB/sに比べて大幅に拡大しており、これが「B200」の高速化実現の要因の一つになっています。

「Blackwell GPU」はTSMCのN4P(4ナノの改良版ライン)で生産される予定です。昨年に一部でTSMC3ナノで生産される計画と報じられましたが、結局、改良版ではありますが、「H100」「H200」と同じTSMC4ナノラインで生産される模様です。これは「Blackwell GPU」は「H100」同様ダイサイズが大きいため生産が難しい一方で、大手クラウドサービス会社から大手企業まで強い需要があるため、大量生産の容易さを考慮したためと思われます。

エヌビディアによれば、「B200」「GB200」は2024年後半に出荷開始となる見込みです。本格的な出荷は2025年に入ってからと思われます。

「B100」「B200」の価格は公表されていません。ただし、「A100」「H100」の日本におけるディーラー販売価格(参考価格)と性能差を参考にすると、「B100」「B200」ともに「H100」「H200」よりも高くなると思われます。「B200」は1個1,000万円以上になる可能性もあります。エヌビディアの競争力は維持されると思われるため、性能向上によるエヌビディア製新型AI半導体の価格上昇は2024年、2025年と続くと思われます。

表1 H100/H200性能比較

表2 H100/B200性能比較(H100に対するB200の性能比較)

3.エヌビディアのAI半導体に対する需要の強さを確認。楽天証券業績予想と今後6~12カ月間の目標株価は変更しない

GTCでは様々な分野の講演会、セミナーが開催されますが、エヌビディアのファンCEOの基調講演はその中核部分です。

ファンCEOの基調講演で分かったことは、エヌビディア自身だけでなく、エヌビディアの大手顧客である大手から準大手、中堅のクラウドサービス会社からのAI半導体の性能向上に対する要求が強いということです。顧客のクラウドサービス会社のデータセンターが電力会社と契約している電力量に対して最大パフォーマンスが発揮できるAI半導体に対する需要が強いということであろうと思われます。推論性能、機械学習性能とともに省エネ性能も重視されるということであり、その成果が「B200」「GB200」であるということであろうと思われます。

そうであるならば、「H100」「H200」に続き、「B200」「GB200」も需要が供給を上回る状態が続くと思われます。また、「B200」「GB200」の省エネ性能が高いことを考えると、2025年に入って「B200」「GB200」の生産量が多くなると、「H100」の更新需要が発生すると思われます。このことを考えると、エヌビディア製AI半導体の需要が供給を上回る状態は2026年頃まで続くと思われます。

また、ファンCEOの基調講演を聴くと、「B200」「GB200」が想定している市場は、エヌビディアの今の主力顧客である大規模データセンターであると思われます。「B100」「B200」搭載サーバーの普及機種が企業向けに入っていくことはあると思われますが、2024年、2025年のエヌビディアの主力事業がデータセンター向けであることは変わらないと思われます。AIサーバーが企業向けに直接大量に出荷されるのは、まだ先になると思われます。

AI半導体はTSMCが生産するGPU部分だけでは生産できないため、SKハイニクス、サムスン電子、マイクロン・テクノロジーが生産するHBMの生産量がAI半導体の生産量を決めることになりそうです。

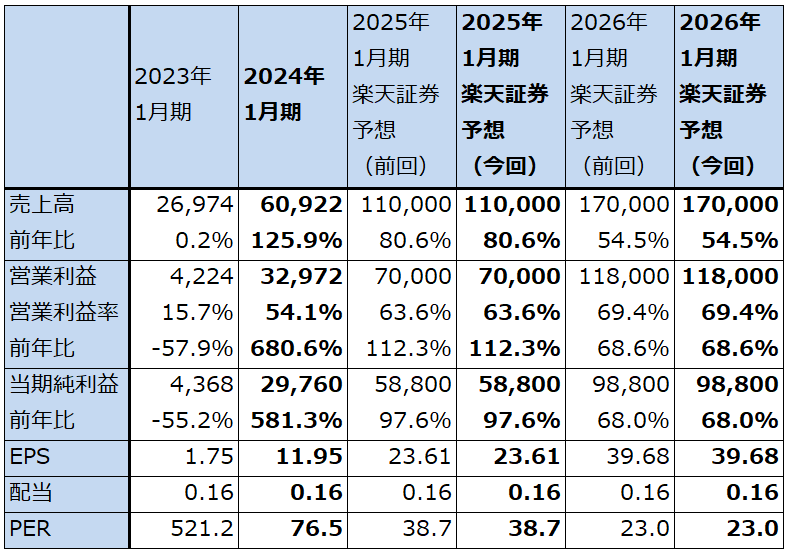

今回は楽天証券の2025年1月期、2026年1月期業績予想は変更しません。少なくとも、表3の楽天証券業績予想を下方修正しなければならない要因は、今回のファンCEOの基調講演からは見つかりませんでした。

エヌビディアの今後6~12カ月間の目標株価は前回の1,400ドルを維持します。

引き続き中長期で投資妙味を感じます。

表3 エヌビディアの業績

時価総額 2,254,787百万ドル(2024年3月21日)

発行済株数 2,490百万株(完全希薄化後、Diluted)

発行済株数 2,466百万株(完全希薄化前、Basic)

単位:百万ドル、%、倍

出所:会社資料より楽天証券作成。

注1:当期純利益は親会社株主に帰属する当期純利益。

注2:EPSは完全希薄化後(Diluted)発行済株数で計算。ただし、時価総額は完全希薄化前(Basic)で計算。

注3:会社予想は予想レンジのレンジ平均値。

![[今週の日経平均と株式市場]バイデン撤退で荒れる米国市場、「カオス」相場の乗り切り方](https://m-rakuten.ismcdn.jp/mwimgs/2/b/160m/img_2b5a074cc6a3e935645125fb974dffcf59165.jpg)

![[動画で解説]【米日株/ドル円】金利大転換 負のスパイラル](https://m-rakuten.ismcdn.jp/mwimgs/8/f/498m/img_8fbfc279050ee52c4455a50cb255123266911.jpg)

![[動画で解説]【再現性あり】新NISAで毎月10万円の不労所得戦略!](https://m-rakuten.ismcdn.jp/mwimgs/7/1/498m/img_712b2a3f8e92e675a04bea2219b5a6f289395.gif)

![[動画で解説]次の節目は2029年?中国「三中全会」で見えた8つのポイント](https://m-rakuten.ismcdn.jp/mwimgs/5/1/498m/img_511b8885e7a23cb985eaf2cbedd16f0b44407.jpg)

![[動画で解説]投資詐欺にだまされないで!怪しい投資話のありがちポイント3選](https://m-rakuten.ismcdn.jp/mwimgs/2/d/498m/img_2d310c68f0e43c0c8d7958574e373aea44780.jpg)

![[動画で解説]桐谷さんの優待生活に突撃!#2 ~桐谷さん、パンパンの優待財布、中身を見せてください!~](https://m-rakuten.ismcdn.jp/mwimgs/e/5/160m/img_e524c4f2812a5f8075a30476512fbf6a66116.jpg)

![[動画で解説]決算レポート:ASMLホールディング(受注が小幅回復。会社側は2025年への強い見方を示す)](https://m-rakuten.ismcdn.jp/mwimgs/c/e/160m/img_ce6a4295321b1700868a384a3e2aa8d944219.jpg)