毎週金曜日午後掲載

本レポートに掲載した銘柄:スーパー・マイクロ・コンピューター(SMCI、NASDAQ)、デル・テクノロジーズ(DELL、NYSE)

1.生成AI、AI半導体、そして、AIサーバー

今回はAIサーバー市場の現状と将来を予想し、その上で、AIサーバーの外販市場において販売シェアトップであるスーパー・マイクロ・コンピューターの再評価と、推定2位のデル・テクノロジーズの決算分析を行いたいと思います。

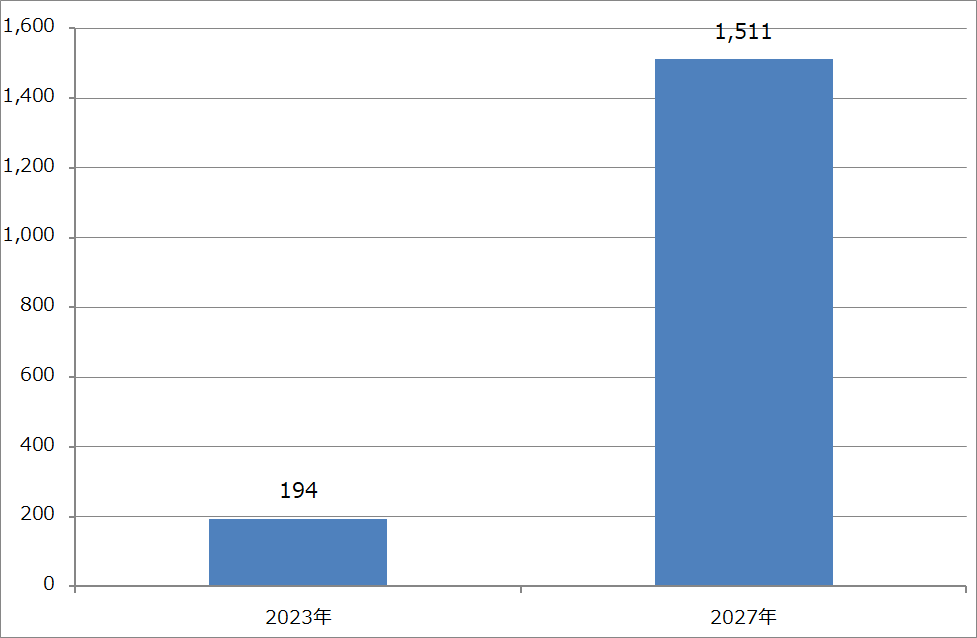

グラフ1は世界の企業の生成AI関連ソリューション(生成AI本体、それに付随するソフトウェア、システムを動かすコンピュータ、ネットワーク機器等)に対する支出額の長期予測です(IDC2023年12月21日プレスリリース)。2023年の194億ドルから2027年の1,511億ドルまで年率86.1%で成長すると予想されています。

同種の予想は2022年11月30日にChatGPTが公開された後にいくつも出ています。2023年春までに出た同種の予測では2020年代後半までに年率30~40%で成長するというものが多かったのですが、昨年後半以降の予測では年率70~80%以上の成長になるという予測が多くなりました。

このように各種の予測が上方修正されている背景は、「私たちは AI について話すことから、AI を大規模に適用することに移行します。」(マイクロソフトの2024年6月期2Q決算電話会議におけるサティア・ナデラCEOの発言)という状況の変化です。要するに、2024年は生成AIを企業や官庁の情報システムに組み込む起点となる年になるであろうということです。これがマイクロソフトのみならず、世界の有力なIT企業の総意だと思われます。マイクロソフトを含む主要IT企業は、生成AIブーム、生成AIを使った情報システムの構築を長期ブームにしたいということでしょう。生成AIの出現は企業や官庁の情報システムに極めて大きなインパクトを与えるものなのです。

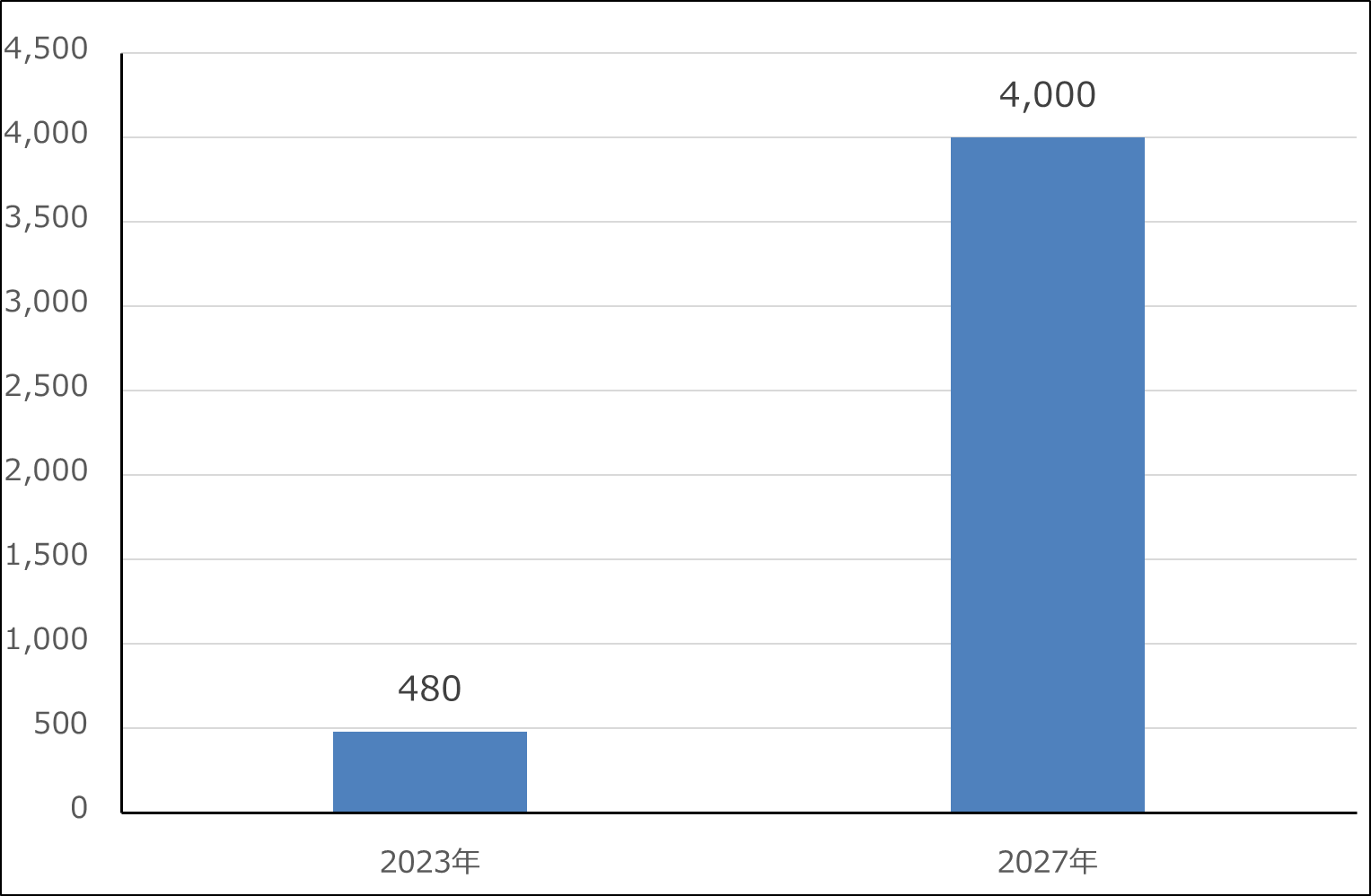

生成AIが企業の情報システムに組み込まれるときに必要なのがAI半導体です。グラフ2は2023年12月にAMDが新型AI半導体「Instinct MI300シリーズ」を発表した時に示した予測です(アナリストの予測として示していました)。これも年率約70%で成長する予想になっています。ただし、エヌビディアの2024年1月期4Q決算を見ると、これ以上の成長率になる可能性もあると思われます。

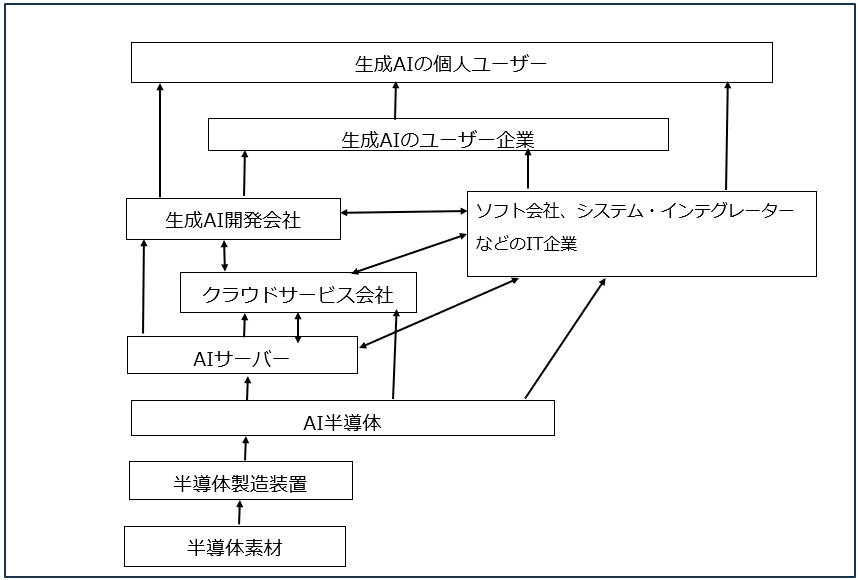

また、図1は生成AIのサプライチェーンです。今後、生成AIとAI半導体が両輪となって生成AIが情報システムに組み込まれていくことになります。そして、生成AIとAI半導体を組み合わせる役割を負うのがAIサーバーです。AIサーバーに組み込まれる各種のソフトウェア、ストレージのようなハードウェア、それ以外のネットワーク機器等も重要になってくると思われます。

生成AIとAI半導体という、単にITの世界のみならず、世界の人々の働き方、企業の在り方から、軍事、医療など様々な分野に大きなインパクトを与えるであろう技術が出てきたときに、有望な投資先を探す場合には、このようなサプライチェーンを常に意識する必要があります。

グラフ1 生成AI関連ソリューションに対する世界の企業支出

グラフ2 AI半導体の世界市場予測

図1 生成AIのサプライチェーン

2.サーバー市場とAIサーバー

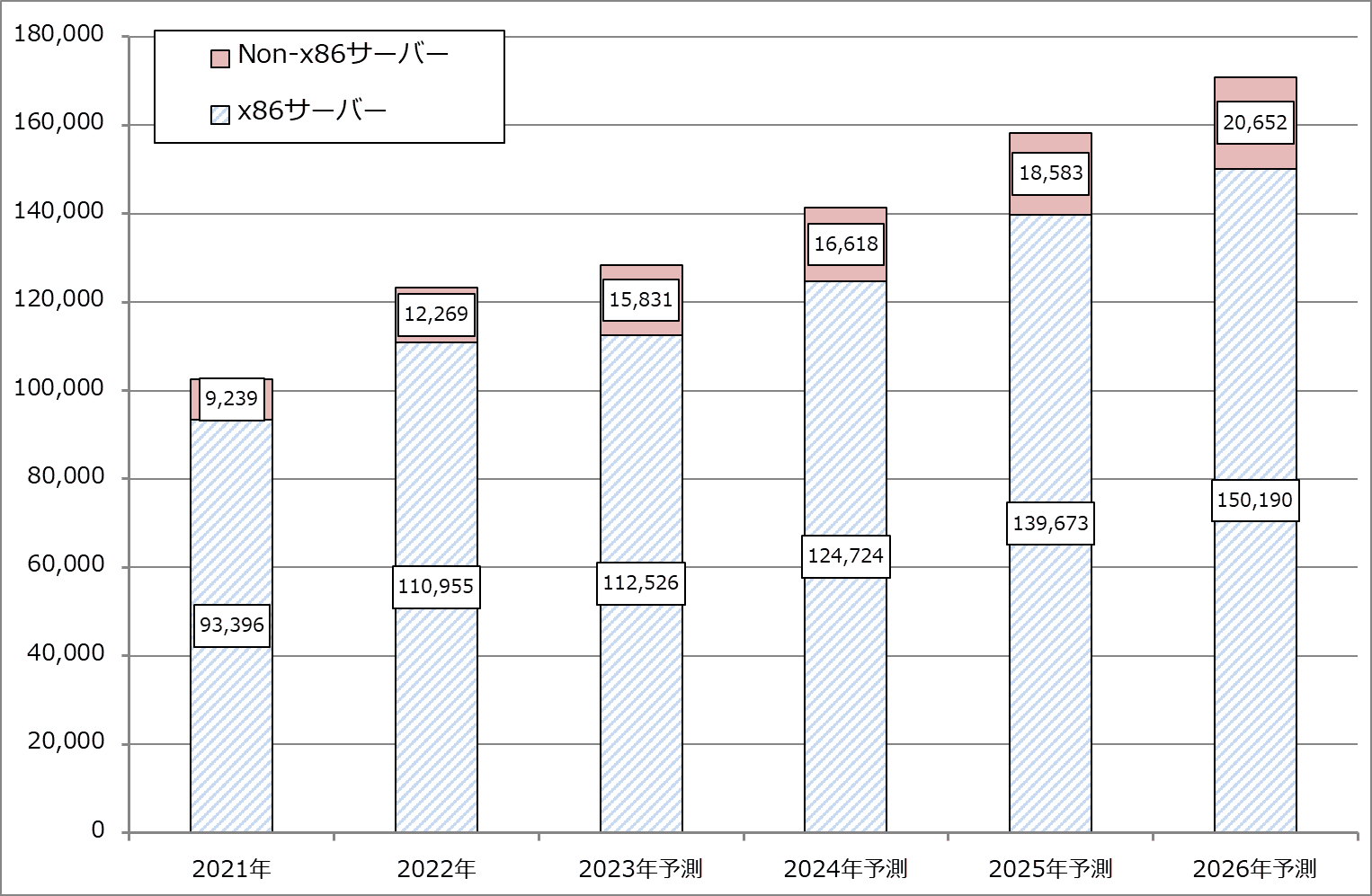

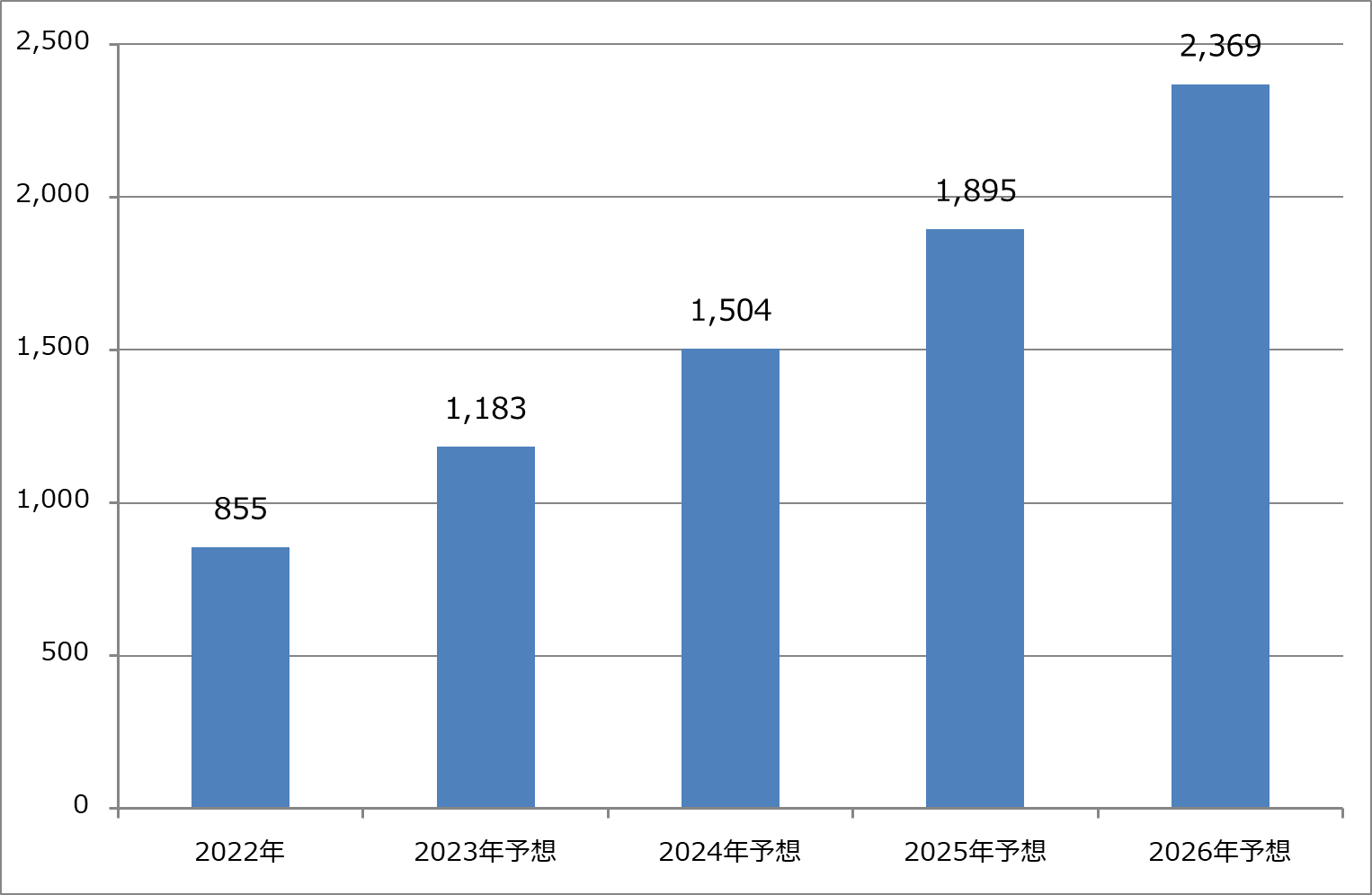

サーバーは、アプリケーションソフトを格納し動かす重要な役割を持っていながら成長率が低いIT市場の中では地味な存在です。グラフ3はサーバー売上高のこれまでの推移と予測を示したものですが、低成長が続いています。

ただし、低率ながらも売上高の成長が続いている理由は、AIサーバーが伸びているためです。調査会社のTrendForceによれば、全サーバー出荷台数に対するAIサーバーの比率(台数比率)は2023年の予測ベースで約9%でした(TrendForce2023年5月30日付けプレスリリース)。これが、2024年には出荷台数の12.1%に拡大する見込みです(同2024年2月29日付けプレスリリース)。なお、TrendForceでは、2024年暦年のサーバー出荷台数を1,365.4万台(前年比2.05%増)としています。

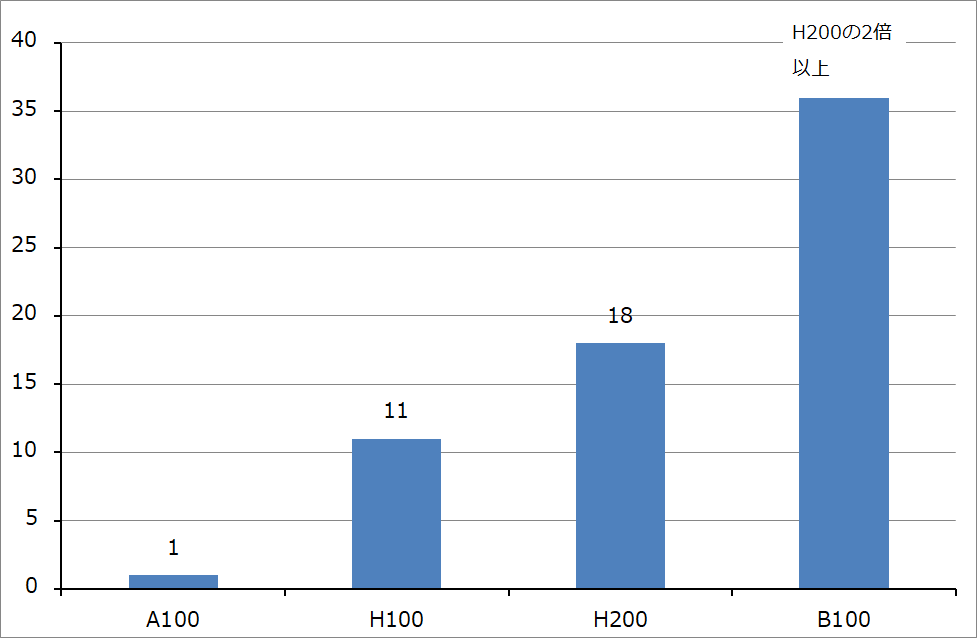

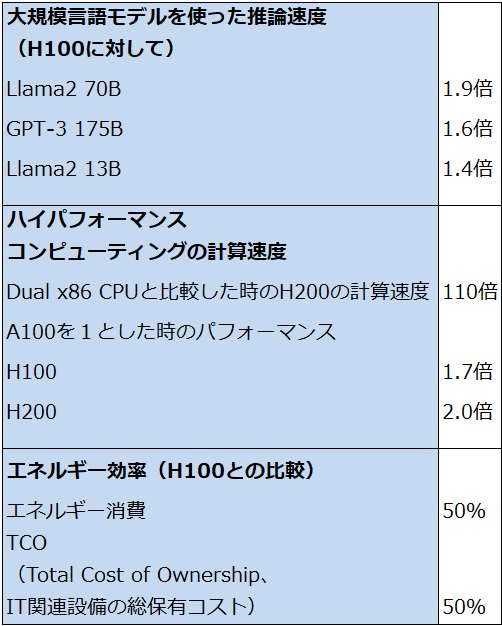

AIサーバーには従来型サーバーにない大きな特色があります。まず、1台当たりの性能が従来のサーバーと比べて桁違いに高性能であることです。例えば、今後出荷される予定のエヌビディアの「GH200」(エヌビディアの高性能CPU「Grace」と「H200」を合体させたもの)を数個搭載したAIサーバーはスーパーコンピュータ並みの能力を持つと思われます。これは「B100」搭載サーバーの最高性能の機種もそうなると思われます。

そして、高額な高性能AI半導体を複数搭載しているため、価格が従来型サーバーに比べて際立って高いことです。従来型サーバー(AI用GPUを搭載しない非AIサーバー)の価格は日本では1台10万円前後から200万円前後です。普通のデータセンターや大手企業のサーバールームであれば、1台数十万円のサーバーを数十台から数百台以上、大規模データセンターであれば、それ以上の台数のサーバーを並べます。

これに対して、AIサーバーはエヌビディアの一世代前のAI用GPU「A100」搭載サーバーが2020~2021年に日本で発売されたときに1台1,100~1,200万円しました。これが現在の主力AI用GPU「H100」搭載サーバーとなると、日本で販売されている「H100」搭載サーバーで価格が確認できるもので7,315万円(税込み)します(「xFusion FusionServer G8600 V7」。スペックは「H100」8基、XeonCPU2基、メモリ2TB、960GBのSSD2基)。スーパー・マイクロ・コンピューター(以下スーパーマイクロ)の最高性能のAIサーバーで、「H100」10基、メインメモリ8TBを搭載しますので、これを日本で購入すると1台8,000~9,000万円はすると思われます。

このようにAIサーバーは、性能と価格が従来と飛びぬけて高いものになっているのです。AI半導体が高額なので、AIサーバーは従来型サーバー(非AIサーバー)よりも利益率が悪いと言われていますが、数多くのAIサーバーを販売することでサーバーメーカーは大きな成長が実現できると思われます。

グラフ3 世界サーバー売上高予測

グラフ4 AIサーバー出荷台数予測

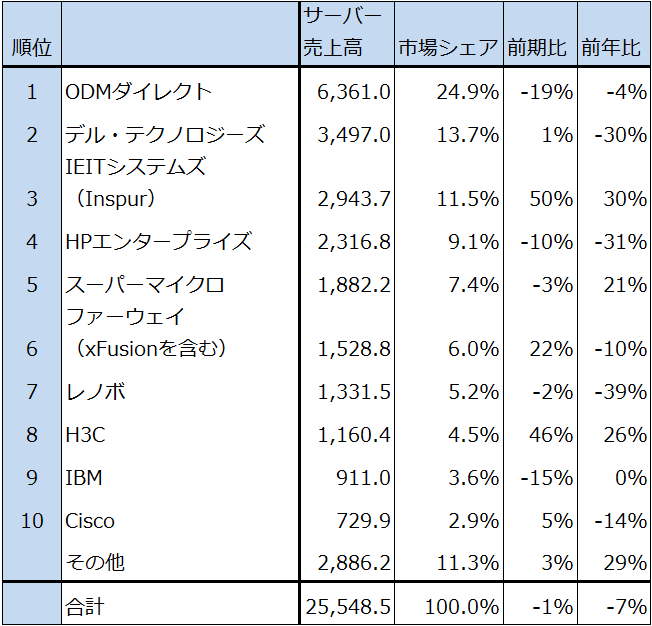

3.サーバーメーカーとAIサーバー

表1は調査会社のオムディアによる2023年3Q(2023年7-9月期)のサーバー売上高ランキングです。1位がODMダイレクト(ODM Direct)となっています。ODM(Original Design Manufacturing)とは、委託者のブランドで製品を設計・生産することです。この場合は大型データセンターを運営する大手クラウドサービス会社と大手SNS会社などからサーバー用半導体の提供を受けて、専用サーバーを開発、生産して生産委託者である大手クラウドサービス会社、大手SNS会社に出荷する業者のことです。

ODM Directの代表例は、台湾のQuanta コンピュータ、電子機器組立業者のフォックスコンなどです。AIサーバーの売上高で最も大きいのは、このODM Directのカテゴリーと思われます。ただし、各ODMメーカーのAIサーバー売上高は不明です。

ODMダイレクトに自社のデータセンターで使うAIサーバーを生産委託している会社が、マイクロソフト、アルファベット、アマゾン・ドット・コム、メタ・プラットフォームズであり、この4社がAIサーバー調達の最大手クラスになると思われます。この場合、「H100」はエヌビディアからマイクロソフトなどが直接仕入れて、生産委託しているサーバーメーカーや電子機器組立業者に渡すことになっていると思われます。

AIサーバーの売上高ランキングを考えるときに、マイクロソフト、アルファベット、アマゾン、メタ・プラットフォームズから生産委託を受けて内製AIサーバーを生産出荷しているODMダイレクトの次に位置するのが、自社ブランドサーバーメーカーのスーパーマイクロになると思われます。表1では中国のInsper(インスパー)もサーバー全体のランキングで上位にランクされていますが、同社は中国メーカーで中国向けが主力であり、高性能のAI用GPUを調達できないはずです。このように考えると、AIサーバーの世界販売ランキングで外販メーカーのトップは、今のところスーパーマイクロであると思われます。2位については推定でデル・テクノロジーズ(以下デル)と思われます。

前回のエヌビディアの決算レポートでも指摘しましたが、エヌビディアのAI半導体の割当基準は、最終顧客の状況を把握したうえで、公平に「H100」を割り当てる、そして稼働していない計画段階のデータセンターには「H100」を供給しないというものであり、既存顧客優先です。このことを考えると、「H100」の次の「H200」、さらにその次の「B100」でも、需要が供給を上回る限り、AIサーバーの外販市場でのスーパーマイクロの優位性は変わらないと思われます。

表1 サーバー売上高ランキング

出所:OMDIA2023年12月6日付けプレスリリースより楽天証券作成

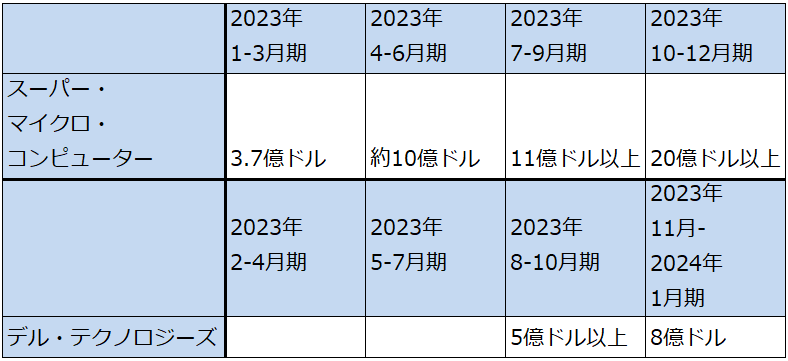

表2 サーバー各社のAIサーバー売上高

出所:スーパーマイクロは、会社資料、発言をもとにした楽天証券推定。デルは決算電話会議での会社側の発言による。

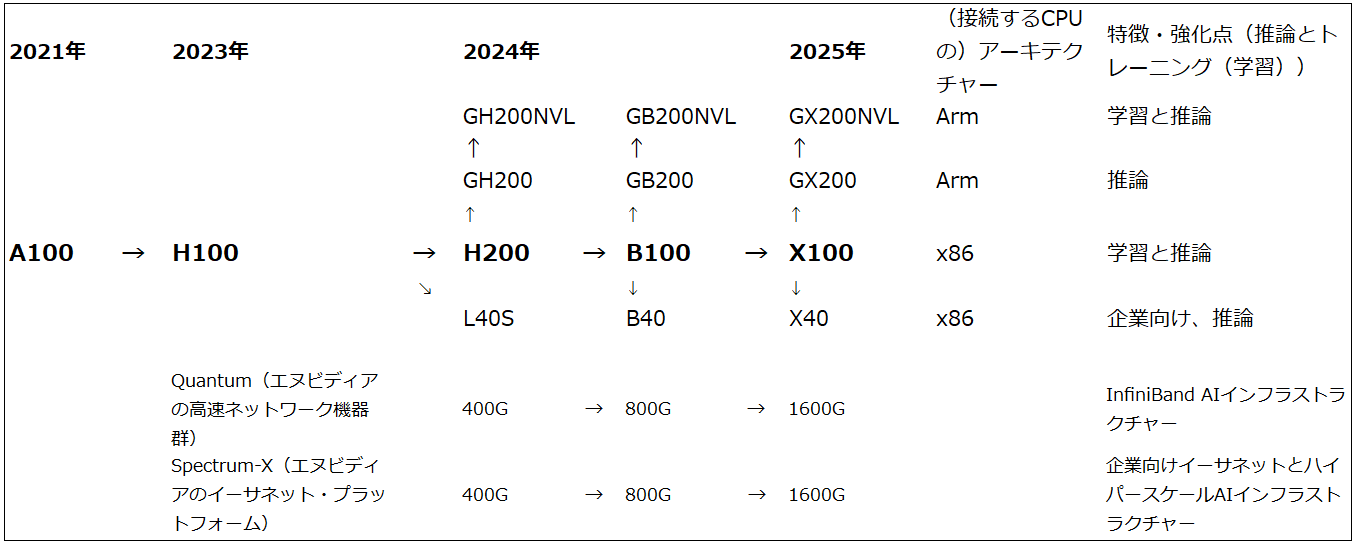

4.AIサーバー市場にとって、エヌビディアの「B100」は大きな転換点となるか

エヌビディアの「H100」には欠点もあります。学習性能(ディープラーニング性能)、推論性能ともに「A100」よりも大幅に強化され、特に従来はCPUで行っていた推論を「H100」で行えるようになりました。一方で、環境性能は悪く、電力消費が多く発熱が多いと言われています。そのため、AIサーバーに強力な水冷冷却装置(サーバーごと冷却水につけてその水を循環させる「液浸冷却」を使う場合がある模様)を装備しなければならず、データセンター側にもこのための設備が必要になります。従って、「H100」搭載AIサーバーは、クラウドサービスであれ、企業の情報システム部門であれ、基本的に大規模データセンター向けになると考えられます。

ただし、エヌビディアの2025年1月期2Qから出荷開始となる「H200」はエネルギー消費量≒電力消費量が「H100」の50%になる見込みです。次世代機の「B100」はこの状況では本格出荷が2025年になる可能性があり、環境性能は今のところ不明ですが、「H200」よりもさらに電力消費量が少なくなる可能性があります。

その場合、「B100」搭載サーバーに使う水冷装置は、「H100」搭載サーバーで使っていると思われる液浸冷却装置(データセンター側で専用設備が必要になる)ではなく、水冷であっても軽装備で十分ということになる可能性があります。この場合、「B100」の供給量が増加すれば、スーパーマイクロの優位性は減じられてしまう可能性があります(スーパーマイクロの優位性の一つは冷却装置にあると同社は決算電話会議でコメントしている)。

ただし、より軽装備の水冷装置でよいとなれば、AIサーバーの需要が一気に中堅クラウドサービス、大手システムインテグレーター、大手企業の情報システム部門、AIのスタートアップ企業の自家保有などに拡大する可能性があると思われます。その場合は、「B100」、さらにはその次の「X100」も需給逼迫が続く可能性があり、エヌビディアの高性能AI半導体の需要が供給を上回る限りそれらを優先的に調達できるというスーパーマイクロの優位性は簡単に低下することはないと思われます。

こうしてみると、早ければ2024年後半に初期出荷が始まり、恐らくは2025年に本格出荷となる「B100」が、AIサーバー市場がさらに拡大する転機となる可能性があります。「B100」に対しては、AIサーバーで出遅れたデル、ヒューレット・パッカード・エンタープライズ(HPE)が注目しています。これらのサーバー大手の優位性は、サーバーに、パソコン、ストレージ、各種ネットワーク機器、ソフトウェアを組み合わせたソリューション販売にあります。スーパーマイクロも、自社の優位性が続いている間に、現在のAIサーバーの単品売りからソリューション販売を付加していく必要があると思われます。

また、AMDの「MI300シリーズ」搭載サーバーも重要な製品になると思われます。

AIサーバーの動きを見るときは、スーパーマイクロと同社を追う形になっているデルの動向に注目したいと思います。

図2 エヌビディアのAI用GPUロードマップ

グラフ5 エヌビディアのAI用GPU:世代毎の推論性能の変化

表3 H100/H200性能比較

![[今週の日経平均と株式市場]バイデン撤退で荒れる米国市場、「カオス」相場の乗り切り方](https://m-rakuten.ismcdn.jp/mwimgs/2/b/160m/img_2b5a074cc6a3e935645125fb974dffcf59165.jpg)

![[動画で解説]【米日株/ドル円】金利大転換 負のスパイラル](https://m-rakuten.ismcdn.jp/mwimgs/8/f/498m/img_8fbfc279050ee52c4455a50cb255123266911.jpg)

![[動画で解説]【再現性あり】新NISAで毎月10万円の不労所得戦略!](https://m-rakuten.ismcdn.jp/mwimgs/7/1/498m/img_712b2a3f8e92e675a04bea2219b5a6f289395.gif)

![[動画で解説]次の節目は2029年?中国「三中全会」で見えた8つのポイント](https://m-rakuten.ismcdn.jp/mwimgs/5/1/498m/img_511b8885e7a23cb985eaf2cbedd16f0b44407.jpg)

![[動画で解説]投資詐欺にだまされないで!怪しい投資話のありがちポイント3選](https://m-rakuten.ismcdn.jp/mwimgs/2/d/498m/img_2d310c68f0e43c0c8d7958574e373aea44780.jpg)

![[動画で解説]桐谷さんの優待生活に突撃!#2 ~桐谷さん、パンパンの優待財布、中身を見せてください!~](https://m-rakuten.ismcdn.jp/mwimgs/e/5/160m/img_e524c4f2812a5f8075a30476512fbf6a66116.jpg)

![[動画で解説]決算レポート:ASMLホールディング(受注が小幅回復。会社側は2025年への強い見方を示す)](https://m-rakuten.ismcdn.jp/mwimgs/c/e/160m/img_ce6a4295321b1700868a384a3e2aa8d944219.jpg)