毎週金曜日午後掲載

本レポートに掲載した銘柄:エヌビディア(NVDA、NASDAQ)、アドバンスト・マイクロ・デバイス(AMD、NASDAQ)、インテル(INTC、NASDAQ)

1.急成長するAI半導体市場

今回のテーマはAI半導体です。AI半導体の現状分析と将来予想を行い、エヌビディア、AMD、インテルのAI戦略を分析します。

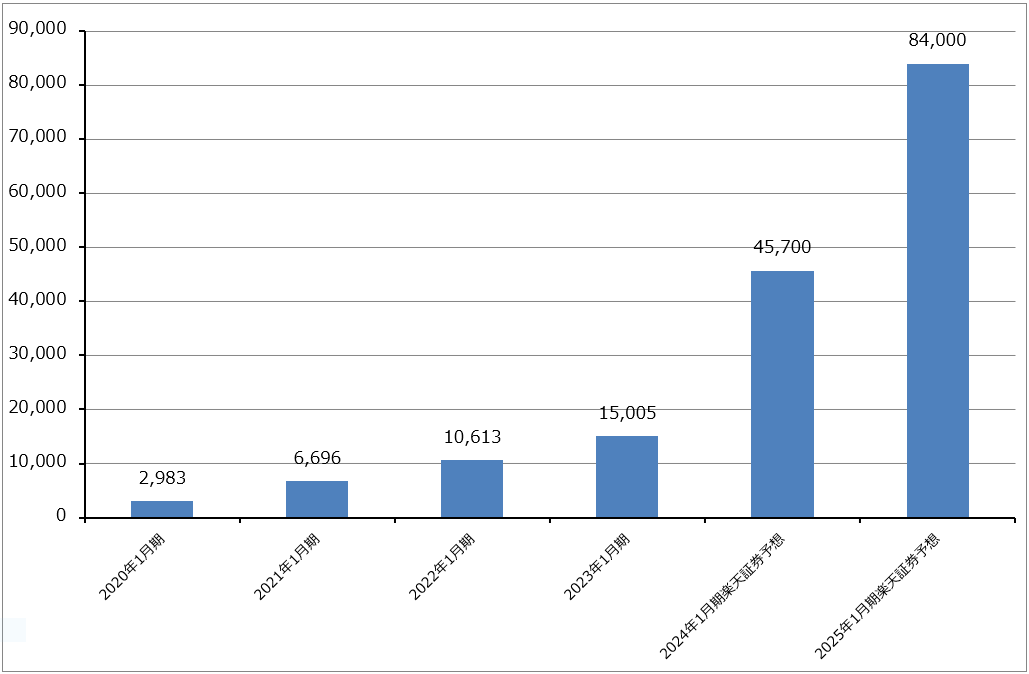

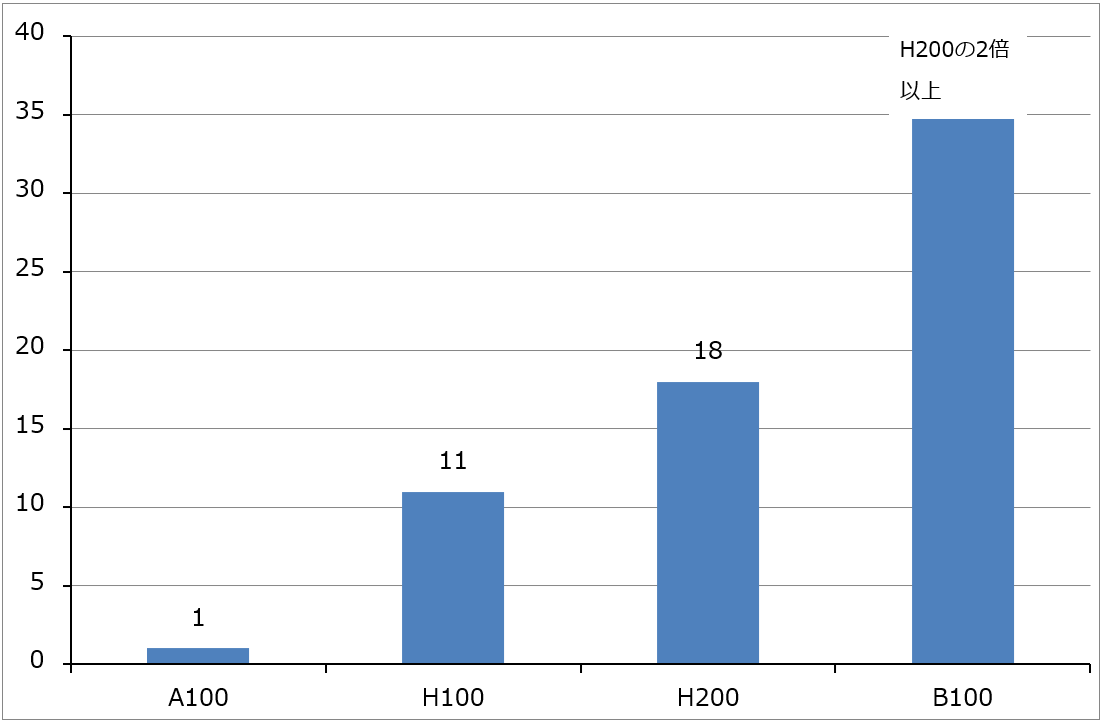

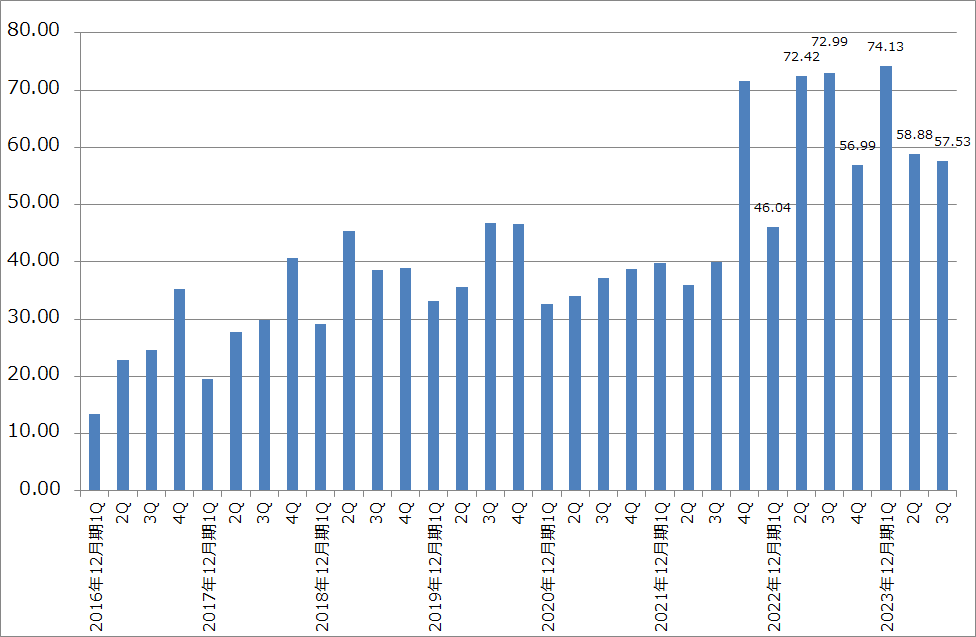

グラフ1はエヌビディアのデータセンター向け売上高の推移を示したものです。楽天証券の推定では、エヌビディアのAI用GPUはAI半導体市場の80~90%前後の市場シェアを占めていると思われます。そのため、エヌビディアのデータセンター向け売上高の動きがAI半導体市場の動きを示していると考えてよいと思います。年度ベースで見ると、エヌビディアのデータセンター向けは、2022年1月期106.13億ドル、2023年1月期150.05億ドル、2024年1月期楽天証券予想457億ドル、2025年1月期楽天証券予想840億ドルとなります。

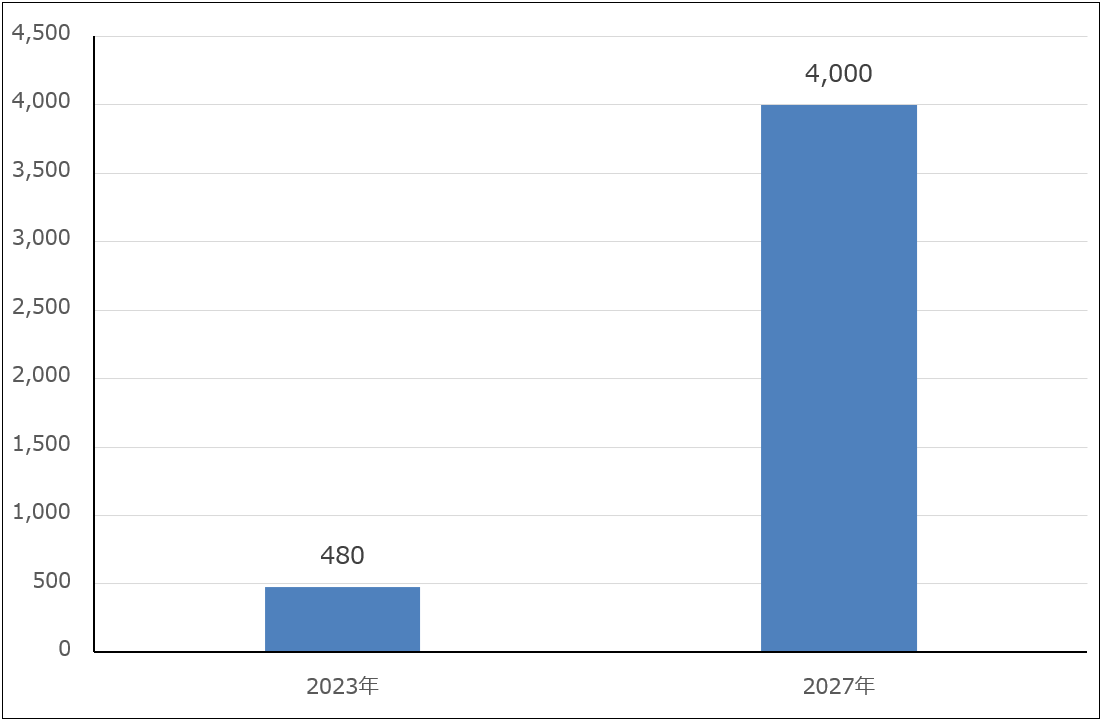

先週の楽天証券投資WEEKLY(楽天証券投資WEEKLY2023年12月15日「特集:GAFAMの生成AI戦略-マイクロソフト、アマゾン、メタ、アルファベット、そしてアップル。各社の生成AI戦略を探る-」)で示した生成AIの市場予測同様、最近のAI半導体の需要予測も強気なものになっています。グラフ2は、AMDの最新型AI用GPU「Instinct MI300シリーズ」の発表会見の際にAMDが示したAI半導体の市場予想です。2023年から年率約70%で成長して2027年には4,000億ドル以上になるという予想です(元出所は不明だが、AMDのCEOはあるアナリストの予想としている)。楽天証券では今のエヌビディアのデータセンター向けの成長率と売上規模から考えて、2027年4,000億ドルというAI半導体の市場規模はあり得ないものではないと考えています。

このようにAI半導体市場が急速に拡大する中で、各プレイヤーも活発に動いています。楽天証券の推定では、AI半導体市場の80~90%がエヌビディア製であり、残りの10~20%は2023年まではアマゾン、アルファベット等の内製AI半導体とその他のAI半導体(各種の電子機器に組み込まれるAIロジック半導体等)、2024年以降はこれらにマイクロソフトとAMDの新型GPU等が加わる見込みです。

そして、この市場が年率70%で急成長する場合は、各プレイヤーが高成長するだけでなく、新興AI半導体メーカーも一定の地位を占めると考えています。大きな市場が急成長するときには隙間も大きくなるからです。

グラフ1 エヌビディアのデータセンター向け売上高

グラフ2 AI半導体の世界市場予測

2.AI半導体とは何か

1)AIを動かすAI半導体

AI半導体は、AIの機能である学習、推論のために使う半導体の総称です。具体的には、AI用GPU、AI用CPU、AIの学習、推論の各々、あるいは両方に特化したロジック半導体を指します。

生成AIを含むAIを動かす場合、AIに大量の学習素材を学習させ(機械学習と、機械学習の中でも人間の脳の仕組みをまねて学習させるディープラーニング)、AIはその学習をもとに推論を行います。もともとは学習、推論ともCPUで行っていましたが、2012年頃複数の大学の研究者から学習はCPUで行うよりもGPUで行ったほうが早くて効率的であるという研究結果が公表されました。そこから学習をGPU、推論をCPUで行う役割分担ができるようになりました。

2)エヌビディア、AMD、インテルのAI半導体

この流れに乗って今日の地位を築いたのがエヌビディアです。特に2022年後半から本格出荷が始まったエヌビディアの「H100」は、ディープラーニング能力だけでなく、推論能力を大幅に高めることによって、AIシステムの駆動の多くをGPUで行うことができるようになりました。

エヌビディアに続いてAMDもAI用GPUを開発、販売しています。2021年11月に「Instinct MI200」シリーズ、2023年12月に「Instinct MI300」シリーズを発売しました。最新型の「MI300」シリーズにはGPUのみの「MI300X」、CPUとGPUを合体させた「MI300A」の2つがあります。

一方インテルは、AI半導体について、CPUのみ(サーバー用CPUの「Xeon(ジーオン)」、パソコン用CPUの「COREシリーズ」で対応)、CPU+GPU(「Xeon」+「Intel Data Center GPU」(開発名「ポンテベッキオ」))、CPU+ディープラーニング専用半導体(アクセラレーター)の「Habana Gaudi2」の3つの選択肢を用意しています。

2番目の「Intel Data Center GPU」はエヌビディアの「H100」を下回る能力なので、売れているようには見えませんが、「Gaudi2」はクラウドサービスが顧客向けのディープラーニング用半導体の選択肢として購入する事例があります。「H100」ほどの能力は必要ないがある程度高いディープラーニング能力は欲しいという顧客向けです。なお、2024年に「Gaudi3」が発売される見込みです。

また、意外に需要が増えているのが、AI処理機能を強化したパソコン用CPUです。AMDが最新型のパソコン用CPUのAI機能を強化し、インテルがそれを追いかける形ですが、このタイプのパソコン用CPUが好調です。

3)クラウドサービスの内製AI半導体と特注型ロジック半導体メーカーのAI半導体

AI半導体には、大手クラウドサービス会社の内製AI半導体もあります。AWS(アマゾン・ドット・コム)のTrainium (学習用)とInferentia(推論用)、グーグル・クラウド(アルファベット)のTPU(テンソル・プロセッシング・ユニット)、Azure(マイクロソフト)のAIアクセラレータ「マイア」(2024年前半に稼働開始)です。いずれも、クラウドサービスの顧客が望む場合に提供されます。

また、ブロードコムのような特注型ロジック半導体メーカー(特定の電子機器メーカーの特定製品に搭載するロジック半導体を設計、販売する)が設計、販売するAI半導体もあります。

4)新興半導体メーカーも重要になる可能性がある

新興企業でAI半導体に取り組む企業も出てきました。AI用GPUはエヌビディア製もAMD製も非常に高性能ですが、大きな問題点があります。AI用GPUはCPUに比べるとダイサイズ(チップサイズ)が大きく、大きなダイの中に大量のトランジスタを構築しているため、電力消費量と発熱量が大きいことです。この問題を克服するために、GPUではなく電力消費量の少ない高性能AI半導体を開発しようとする動き(アメリカの新興企業「テンストレント」)、「H100」のような高性能AI半導体は必要ないというユーザーのために、推論に特化し、小型で電力消費量が少なく安価なAI半導体を開発する動きもあります(アメリカの「dマトリックス」)。

AI半導体市場が巨大なものになれば、これらの新興企業のAI半導体に対する需要も大きくなる可能性があります。

3.エヌビディアの「H100」対AMDの「MI300シリーズ」、高性能なのはどちら?

1)AMDによる「MI300」と「H100」の比較

今のAI半導体市場を主導している製品は、エヌビディアの「H100」です。世界中から極めて強い需要があり、増産していますが品不足が続いています。これに対して、AMDは12月6日に新型AI半導体「Instinct MI300」シリーズの発表会を開催しました。すでに大手サーバーメーカーに出荷しており、マイクロソフトAzureでも提供される予定です。GPUのみの「MI300X」とCPU、GPU合体型の「MI300A」があります。

この「MI300」シリーズとエヌビディアの「H100」の性能比較が話題になっています。12月6日の発売会見において、AMDは「H100」との性能比較を示しました。それによれば、

- 両方のチップをサーバーに各々8基搭載し大規模言語モデルで比較した場合(「MI300X Platform」と「H100 HGX」の比較)、「MI300X Platform」の推論性能は「H100 HGX」に対して「Bloom」(オープンソースの大規模言語モデル)でスループット(単位時間あたりに処理できるデータ量)が1.6倍、「Llama2」(メタ・プラットフォームズが開発した大規模言語モデル)でチャット時の遅延改善度合いが1.4倍になった。学習性能では同等だった。

- 大規模言語モデルを動かしたときの性能は、学習、推論とも、「MI300X Platform」は「H100 HGX」H100の約2倍。

- 「GH200」(まだ発売されていない)と「MI300A」を比較すると、単位電力量当たりのHPCパフォーマンス(AIではなく通常のコンピュータとして使った場合)は2倍。

- OpenFOAM(数値解析開発、数値流体力学を含む連続体力学のオープンソースソフトウェア)を動かした場合は、「MI300A」は「H100」の4倍のパフォーマンスになる。

2)エヌビディアの反論とそれに対するAMDの反論

これに対してエヌビディアは、AMDが「MI300X」と「H100」のパフォーマンスを比較する際に、「H100」用に最適化されたソフトウェア「TensorRT-LLM」を使用していなかったと反論しました。NVIDIAによると、「H100」のようなAI特化型チップはNVIDIA独自のソフトウェア「TensorRT-LLM」を使うことで最適な動作を行うように設計されています。NVIDIAは「TensorRT-LLM」を用いた際の「MI300X」と「H100」のパフォーマンスを比較していますが、1秒間に処理できるクエリの数を比較した結果、圧倒的に「H100」が「MI300X」の性能を上回ったと報告しました(この件に関する報道のグラフを見ると、「H100」は「MI300X」に対して4~10倍以上のパフォーマンスになる)。

これに対して、AMDは、お互いにvLLM(大規模言語モデルの処理スピードを高めるライブラリ。オープンソース)を利用した場合(FP8=浮動小数点演算の1形式で計算した場合)、「MI300X」が「H100」の約2.1倍のスコアを示したと報告しました。

3)「H100」と「MI300」シリーズの優劣は市場で測るしかない

「H100」と「MI300X」のどちらが優秀か、メーカー同士が比較しても正しい結果を得ることは難しいと思われます。「MI300X」搭載AIサーバーが市場に出回る2024年前半になって、中立的な立場の技術系メディアやITコンサルティング会社が同じ条件のセッティングで複数の大規模言語モデルを動かすベンチマークテストを行うのを待つしかありません。

ちなみに、2020年に発表された「MI200」シリーズは、GPU単独でのスペックはエヌビディアの「A100」を上回っていましたが、「MI200」シリーズと「A100」を各々サーバーに装着してAIを動かしてみると、数字は全ての分野で「A100」搭載サーバーが上回っていたと言われています。このため、「MI200」シリーズは市場シェアを取れませんでした(推定シェアは5%未満)。これはエヌビディアがエヌビディア製GPU搭載AIサーバーを使って効率的にAIシステムを開発し動かすために揃えている開発支援ソフトウェア群が優秀であるためです。エヌビディアの全従業員の50%以上がこのようなソフト開発に従事するソフトウェアエンジニアです。

今回はAMDも開発支援ソフトウェアを充実させていますが、この分野ではエヌビディアに先行優位性があると思われます。結局これは、「MI300」シリーズ搭載サーバーが市場に行き渡ってからの評価を待つしかありません。

4)「H100」が優秀なAI半導体であることは実証されたと思われる

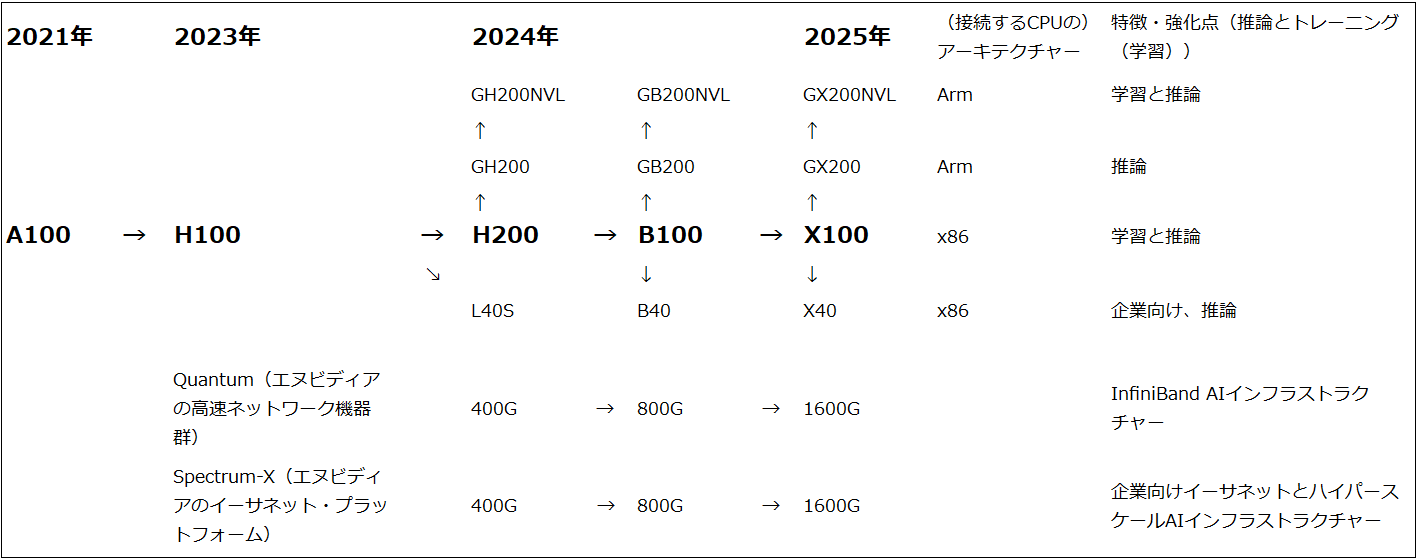

AMDの主張で注目すべきことがあります。「H100」が発表されたのは2022年3月、出荷開始は、2022年10月(2022年8-10月期)です。これに対して、AMDが「MI300」シリーズを発表したのは2023年1月、2023年7月と12月に詳細情報を公開し、12月の詳細情報公表と同時にすでに出荷開始したことを発表しました(出荷開始は2023年10-12月期)。「H100」の発表時期2022年3月と「MI300」の2回目の詳細情報公表時期2023年12月とは1年9カ月離れており、出荷時期も1年2カ月離れているにもかかわらず、大規模言語モデルを動かしたときの性能差が約2倍でしかありません。出荷開始時期が1年以上離れていることを考えると、「MI300X」は「H100」以上の性能で当然です。一部報道で2024年4-6月期投入と言われているエヌビディアの次世代AI用GPU「B100」は、「H100」の3倍以上の性能になるとエヌビディアは指摘しています(図1、グラフ3)。

実際のところ、「MI300」シリーズが競合するのは「H100」ではなく、2024年前半に投入されると思われる「H200」(「H100」のHBM(AI半導体に必ず付ける特殊メモリ)を増強したもの)とその上位機種である「GH200」、そして、次世代機「B100」になると思われます。「MI300」シリーズが「H200」と「GB200」に対してある程度競争力があったとしても、「B100」に負けるようなことがあれば、AMDのAI用GPUはエヌビディアの補完としての位置づけになると思われます。

このように見ると、「H100」を生み出したエヌビディアの開発能力の高さが改めて注目されます。また、今の生成AIブームが続く限り、エヌビディア製AI用GPU、特に最新型シリーズの品不足が続く可能性があります。その場合、AMDの「MI300」シリーズ、AWS、グーグル・クラウド、Azureの内製AI半導体は、エヌビディアの補完製品として好調に売れる、あるいは使われると予想されます。

図1 エヌビディアのAI用GPUロードマップ

グラフ3 エヌビディアのAI用GPU:世代毎の推論性能の変化

4.AI半導体各社の業績動向と投資評価

エヌビディア

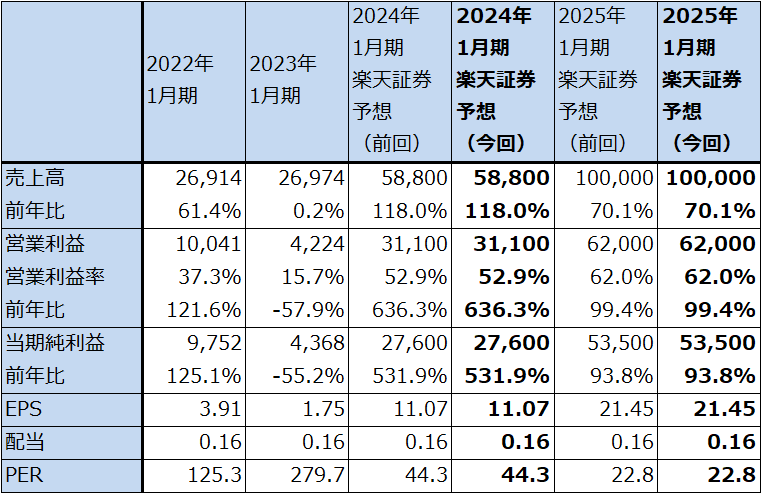

エヌビディアの楽天証券業績予想と今後6~12カ月間の目標株価760ドルは変更しません。2024年前半に投入されるであろう「H200」「B100」と2025年の「X100」に期待したいと思います。

引き続き中長期で投資妙味を感じます。

表1 エヌビディアの業績

時価総額 1,209,073百万ドル(2023年12月21日)

発行済株数 2,494百万株(完全希薄化後、Diluted)

発行済株数 2,468百万株(完全希薄化前、Basic)

単位:百万ドル、%、倍

出所:会社資料より楽天証券作成。

注1:当期純利益は親会社株主に帰属する当期純利益。

注2:EPSは完全希薄化後(Diluted)発行済株数で計算。ただし、時価総額は完全希薄化前(Basic)で計算。

表2 エヌビディアの市場別売上高(年度)

出所:会社資料より楽天証券作成

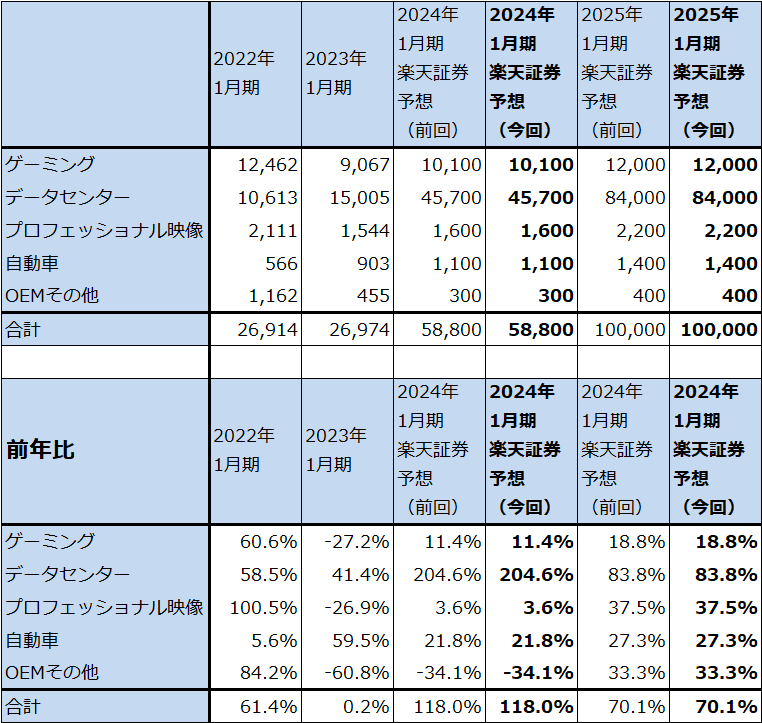

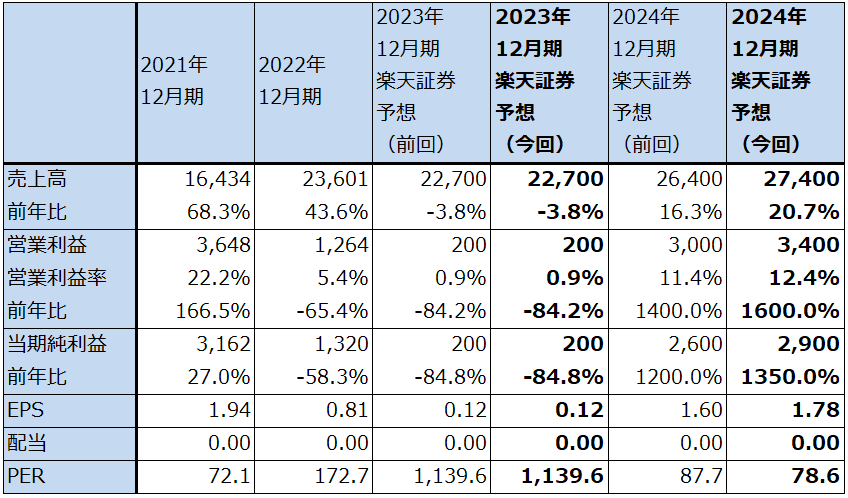

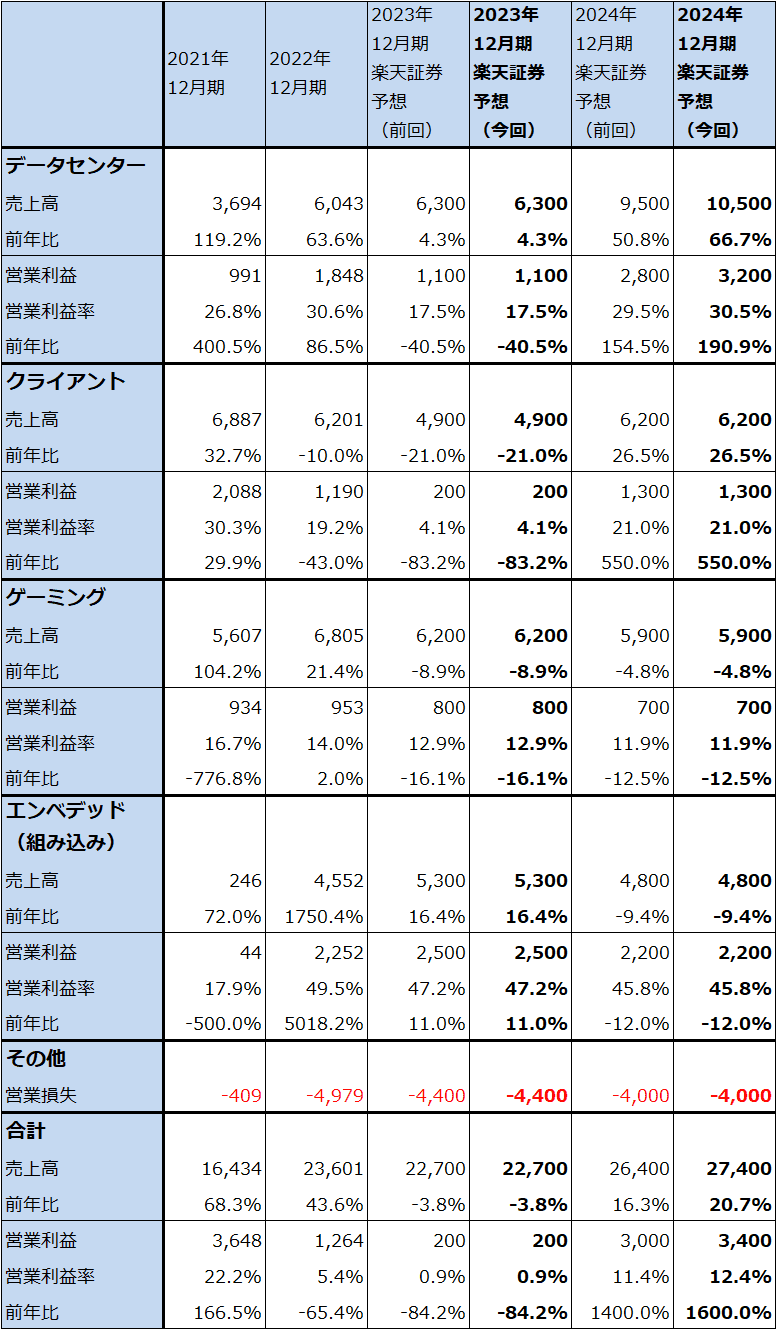

AMD

AMDの2024年12月期楽天証券業績予想を上方修正します。前回の楽天証券予想(楽天証券投資WEEKLY2023年11月10日)では、AMDのデータセンター・セグメントの売上高予想を、2023年12月期63億ドル(うちサーバー用CPUその他59億ドル、データセンター用GPU(主にMI300シリーズ)4億ドル(会社予想と同じ))、2024年12月期95億ドル(サーバー用CPUその他75億ドル、データセンター用GPU20億ドル(会社予想と同じ))としました。

今回予想では、データセンター・セグメント売上高を、2023年12月期63億ドル(内訳は前回予想と同じ)、2024年12月期105億ドル(うちサーバー用CPUその他75億ドル、データセンター用GPU30億ドル)として、2024年12月期を上方修正しました。この予想は、「MI300」シリーズを生産するTSMC6/5ナノラインに十分な生産余力があることを前提しています。

また、クライアント・セグメントでは、在庫調整がほぼ終わった2023年12月期3Qに最新型の生成AI処理能力強化型のパソコン用CPUがヒットしています。この流れは来期も続くと予想されます。この見方は、前回予想と同じです。

一方で、ゲーミングは、PS5と新型Xboxのピークアウトによって今期、来期とも減収減益、エンベデッドは通信機器向けの在庫調整によって今期は業績鈍化、来期は減収減益となって、この2セグメントは今期、来期とも全社業績のマイナス要因になると思われます。この見方も前回予想と同じです。

このような見方から、楽天証券ではAMDの2023年12月期業績予想を前回と同じとしますが、2024年12月期は前回予想の売上高264億ドル(前年比16.3%増)、営業利益30億ドル(同15.0倍)を、売上高274億ドル(同20.7%増)、営業利益34億ドル(同17.0倍)へ上方修正します。セグメント別では、データセンター・セグメントの2024年12月期予想を、前回の売上高95億ドル(同50.8%増)、営業利益28億ドル(同2.5倍)から、売上高105億ドル(同66.7%増)、営業利益32億ドル(同2.9倍)へ上方修正します。

今後6~12カ月間の目標株価は、前回の150ドルを180ドルに引き上げます。2024年12月期楽天証券予想EPS(1株当たり利益)1.78ドルに変化率の大きさを考慮して想定PER(株価収益率)を100~110倍としました。

引き続き中長期で投資妙味を感じます。

表3 AMDの業績

時価総額 226,095百万ドル(2023年12月21日)

発行済株数 1,629百万株(完全希薄化後、Diluted)

発行済株数 1,616百万株(完全希薄化前、Basic)

単位:百万ドル、%、倍

出所:会社資料より楽天証券作成。

注1:当期純利益は親会社株主に帰属する当期純利益。

注2:EPSは完全希薄化後(Diluted)発行済株数で計算。ただし、時価総額は完全希薄化前(Basic)で計算。

表4 AMD:セグメント別業績(通期)

出所:会社資料より楽天証券作成

インテル

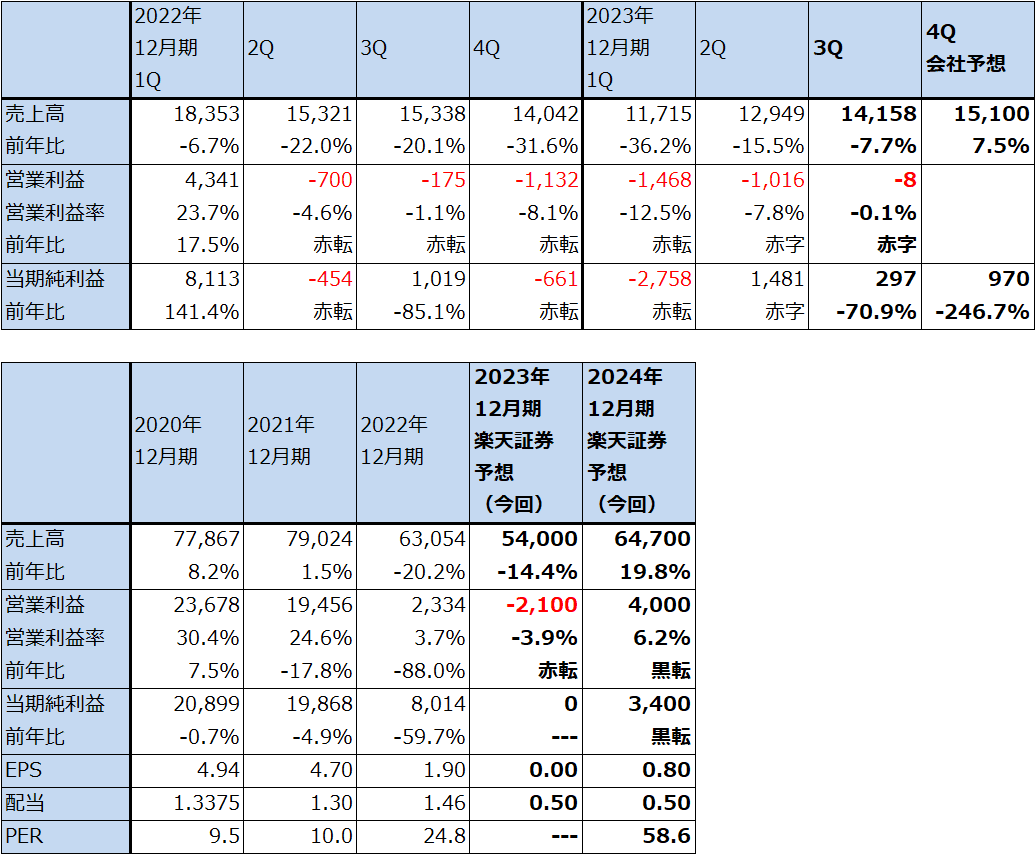

1)2023年12月期3Qは7.7%減収、営業赤字800万ドル

インテルの2023年12月期3Q(2023年7-9月期、以下今3Q)は、売上高141.58億ドル(前年比7.7%減)、営業損失800万ドル(前年同期は1.75億ドルの赤字)となりました。1年前に比べると減収ですが、赤字幅は縮小、今2Q比では増収、赤字幅縮小となりました。パソコン用CPU、サーバー用CPUの生産体制の整備と継続的なコストダウンが奏功し、黒字転換まであと一歩の所まできました。

表5 インテルの業績

時価総額 197,830百万ドル(2023年12月21日)

発行済株数 4,229百万株(完全希薄化後、Diluted)

発行済株数 4,202百万株(完全希薄化前、Basic)

単位:百万ドル、%、倍

出所:会社資料より楽天証券作成。

注1:当期純利益は親会社株主に帰属する当期純利益。

注2:EPSは完全希薄化後(Diluted)発行済株数で計算。ただし、時価総額は完全希薄化前(Basic)で計算。

注3:会社予想は予想レンジの平均値。

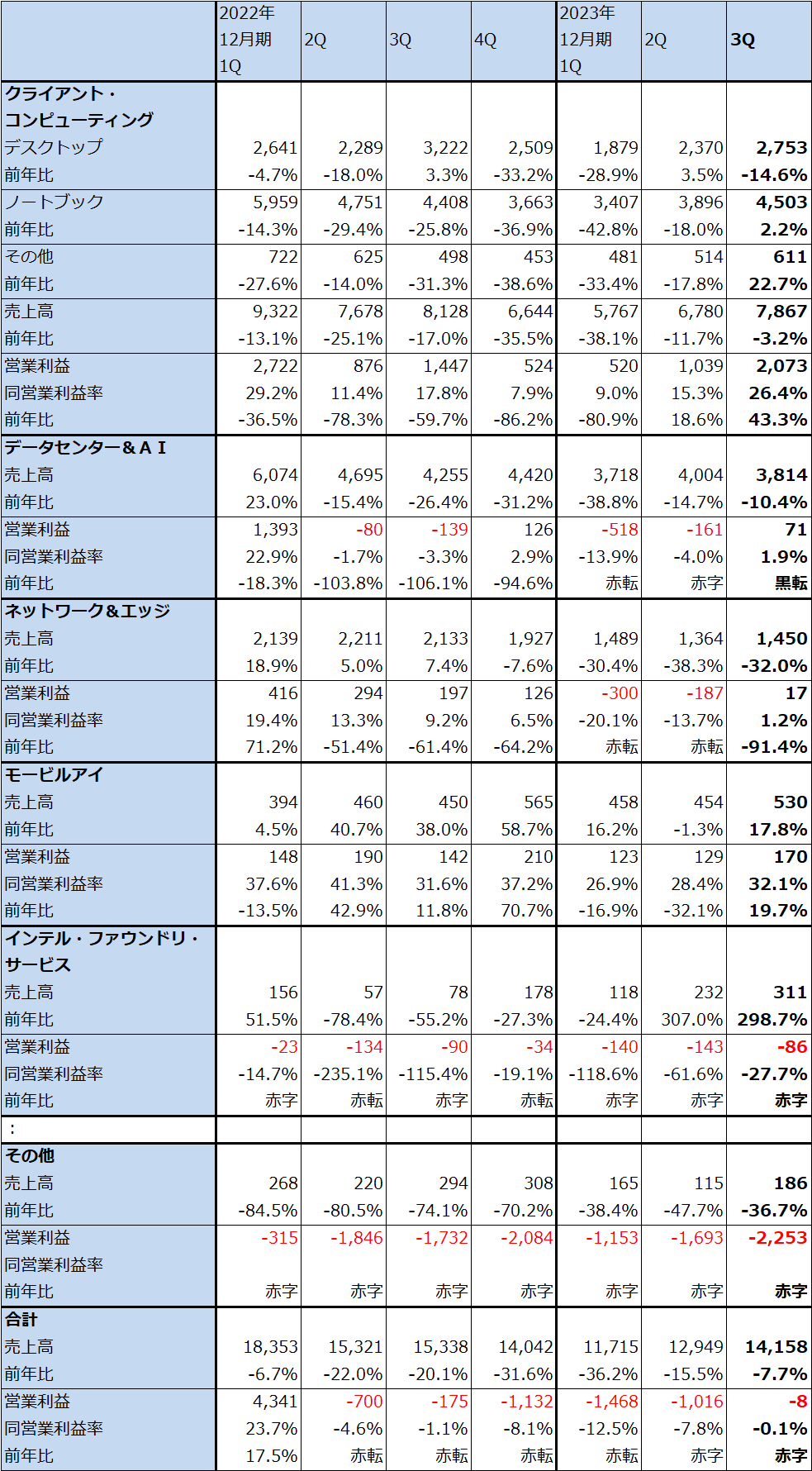

2)セグメント別動向

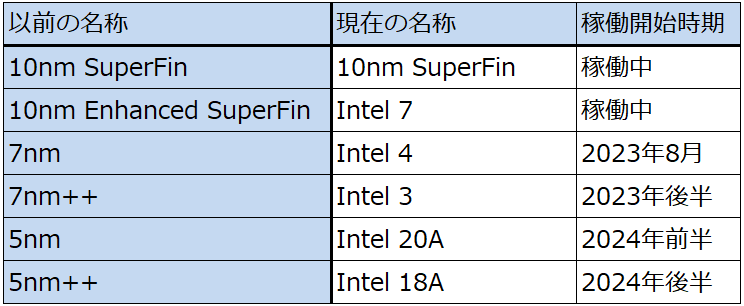

クライアント・コンピューティング:今3Qのクライアント・コンピューティング(主にパソコン用CPU)は、売上高78.67億ドル(前年比3.2%減)、営業利益20.73億ドル(同43.3%増)となりました。1年目に比べると小幅減収でしたが、「インテル7」(TSMC10ナノ相当)の稼働率が高かったこと、新生産ライン「インテル4」(TSMC7ナノ相当)の稼働開始とパソコン用CPUの新製品「メテオ・レイク」(開発名、製品名は「Core Ultra」)の初期出荷を開始したこと等により、営業利益率が大きく改善しました。メテオ・レイクは、AI処理能力を向上させたパソコン用CPUで、現在需要が拡大している分野の新製品です。2022年から続いてきたパソコン用CPUの在庫調整がほぼ終了したことも寄与しました。

また、インテル4以降の生産ラインはEUV露光装置を使うため、効率生産が実現できる見込みです。

当面は、デスクトップ向け、ノートブック向けともに売上高が回復、再成長に向かい、営業利益の回復も続くと予想されます。生成AIブームがサーバーだけでなくパソコンに波及したことは追い風です。

データセンター&AI:今3Qのデータセンター&AIは、売上高38.14億ドル(前年比10.4%減)、営業利益7,100万ドル(前年同期は1.39億ドルの赤字)となりました。前年比、今2Q比とも減収でしたが、黒字転換しました。ただし、サーバー用CPU市場が弱い状態が続いているため勢いはありませんでした。

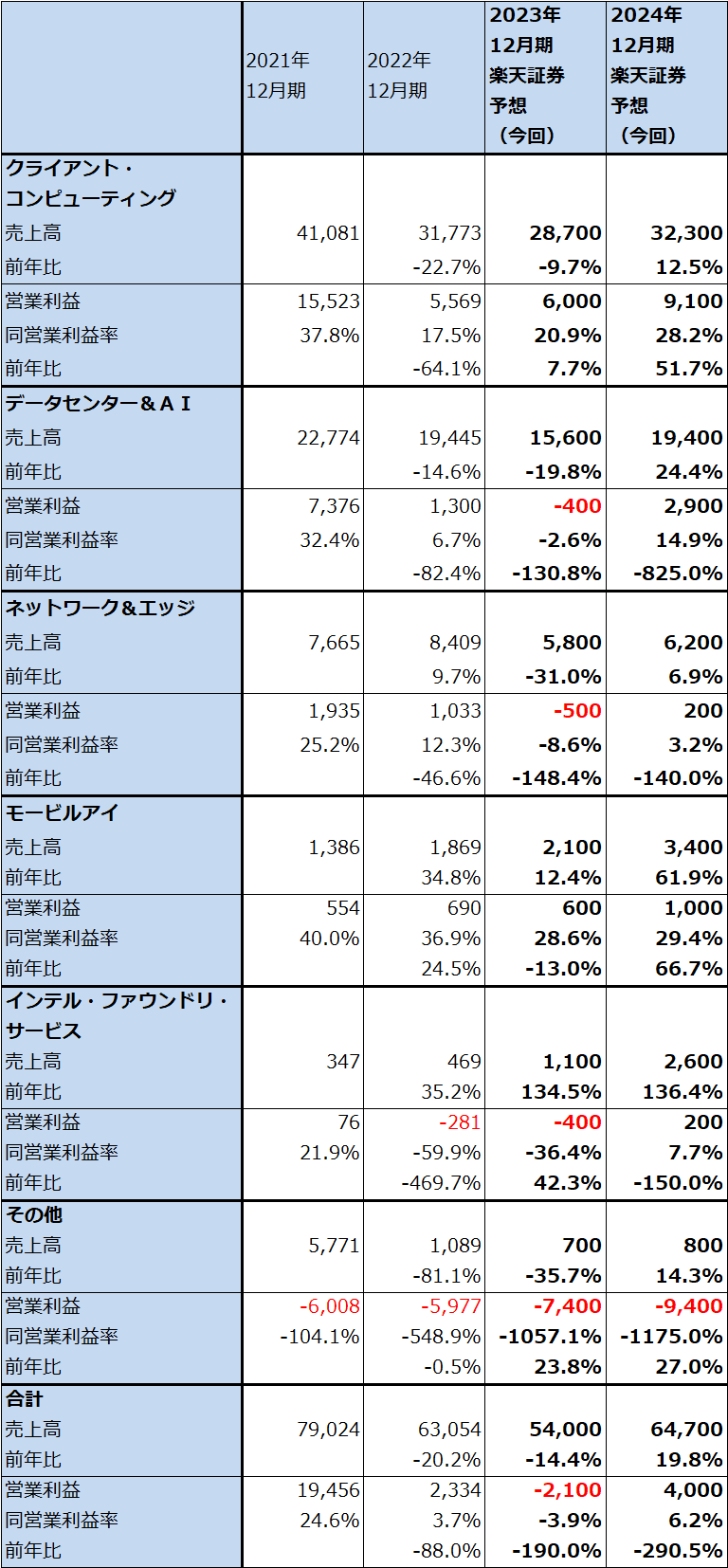

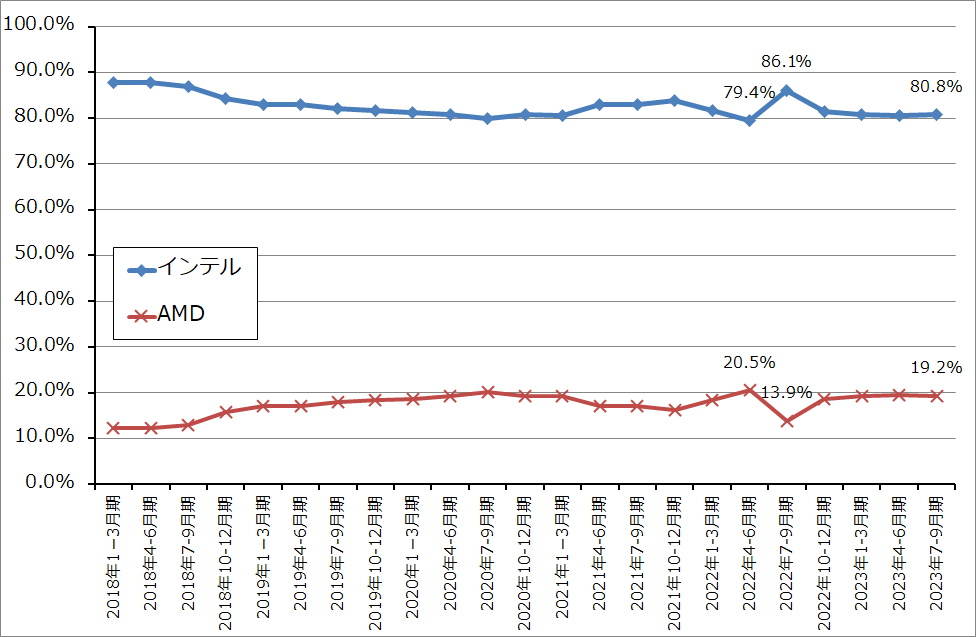

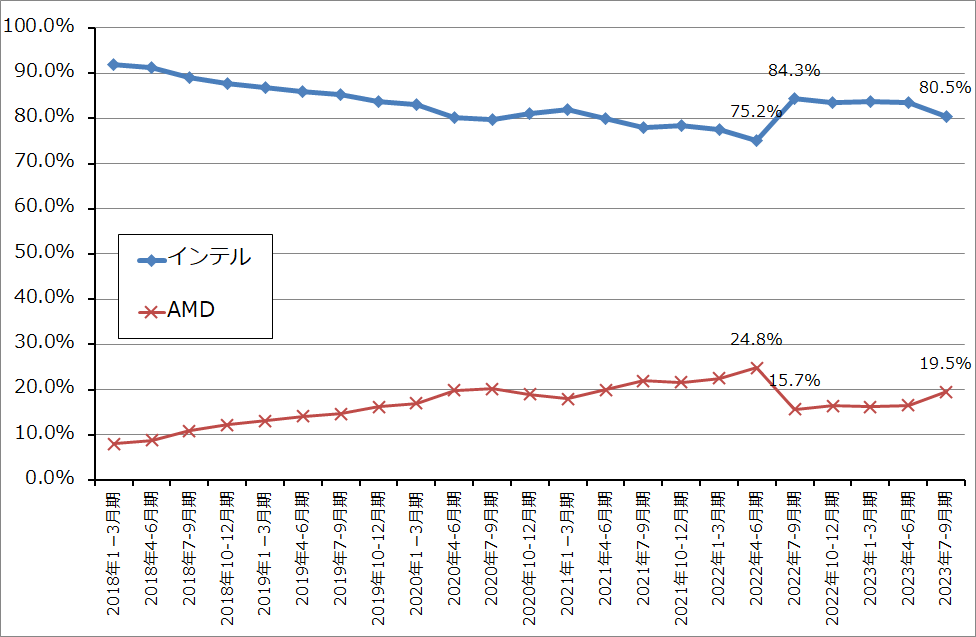

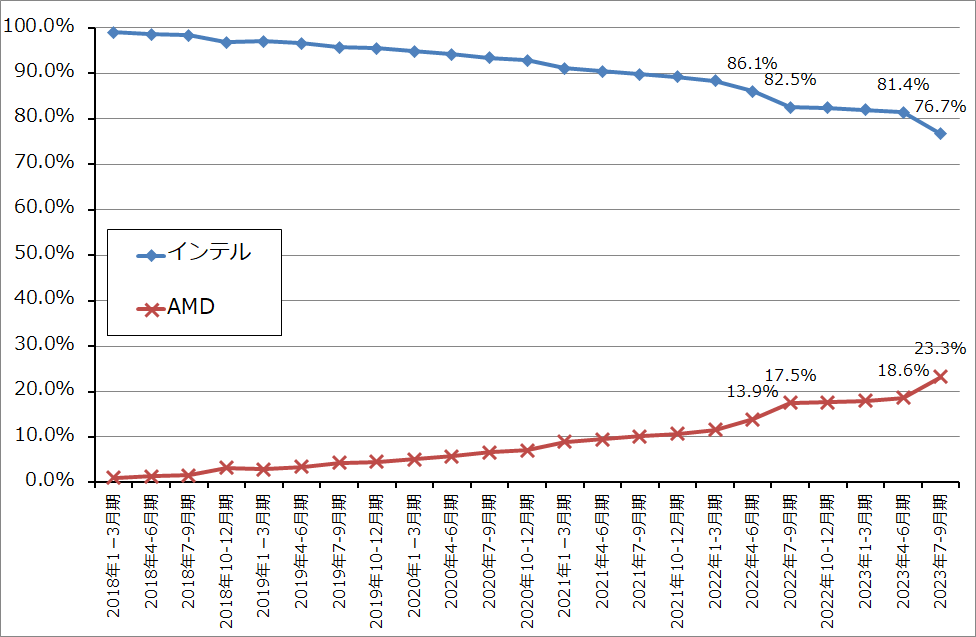

今3Qまでは生産設備は「インテル7」(TSMCの10ナノ相当)を使っているため、競合するAMD(最新型のサーバー用CPUはTSMC4ナノで生産)に比べ競争力はありません。グラフ5~7はデスクトップ向け、モバイル向け(ノートブック向け)、サーバー向けCPUの市場シェアを表したものです。デスクトップ向け、モバイル向けではインテルの市場シェアは大きく落ちているわけではありませんが、サーバー用CPUでは市場シェアの低下が目立ちます。

ただし、今4Q以降はインテルのサーバー用CPUに変化が期待できそうです。2023年10月にサーバー用CPUの新型「エメラルド・ラピッズ」(インテル7で生産)を出荷開始しました。2023年年末までに「インテル3」(TSMC5ナノ相当)の製造準備が整う予定ですが、最新型サーバー用CPU「シェラ・フォレスト」「グラナイト・ラピッズ」がインテル3で生産されます。この2製品は2024年前半に出荷開始されると思われますが、「エメラルド・ラピッズ」も含めてこれまでの製品よりも価格が高いため、今期、来期の業績に寄与すると思われます。ちなみに「グラナイト・ラピッズ」はAI処理機能を強化したものです。

また、2024年前半に生産準備が完了する予定の「インテル20A」(TSMC5ナノ相当)、2024年後半に生産準備が完了する予定の「インテル18A」(TSMC5ナノの拡張版相当)が稼働してパソコン用CPUとサーバー用CPUが生産できるようになれば、競争力は回復すると思われます。

なお、データセンター&AIに含まれるFPGA事業(旧アルテラ事業)は今3Qまでは順調に伸びていますが、一時的な在庫調整で今4Qは業績が悪化する見込みです。FPGA事業は2~3年後をめどにIPO(株式の新規公開)してインテルから分離する計画です。

ネットワーク&エッジ、モービルアイ、インテル・ファウンドリ・サービス:ネットワーク&エッジはインテルが得意な分野ではなく、振るわない展開が続いています。自動運転、自動ブレーキ事業のモービルアイは、順調に推移しています。

インテル・ファウンドリ・サービス(IFS)は、インテルの将来の成長ドライバーとして期待がかかる事業です。売上高はまだ小さく、赤字ですが、四半期ごとに前期比増収になっています。今年から来年にかけて「インテル4」から「インテル18A」までの生産体制が整備されることはIFS事業にとって重要です。

その他セグメント:その他セグメントの赤字の中に、各セグメント以外の事業収益、リストラ費用、従業員の福利厚生、報酬、配賦不能営業費用、買収関連費用(買収に伴う無形資産、のれんの減損を含む)が含まれています。この赤字は全社の中でも大きく、四半期ごとに増減しています。この赤字を吸収するだけの業績回復、拡大がクライアント・コンピューティングとデータセンター&AIの主力2事業で実現できるのかが今後のポイントになります。

表6 インテルのセグメント別業績(四半期)

出所:会社資料より楽天証券作成

表7 インテルの半導体製造プロセス

グラフ4 インテル:設備投資(四半期ベース)

3)今4Qは黒字転換か。2024年12月期は通期で黒字転換へ。

インテルにとっての主力2事業、クライアント・コンピューティング、データセンター&AIは、生産体制の整備と新製品の投入が続くため、今4Q以降も業績回復と再成長が期待できます。一方、ネットワーク&エッジは当面は業績低迷が続くと思われます。モービルアイ、IFSは順調が予想されますが、事業規模が小さいため、全社業績への寄与は小さいものとなる見込みです。

そのため、インテルの全社業績は2023年12月期4Qに黒字転換し、2024年12月期は通期で黒字転換すると予想されます。楽天証券ではインテルの全社業績を、2023年12月期売上高540億ドル(前年比14.4%減)、営業損失21億ドル(2022年12月期は23.34億ドルの黒字)、2024年12月期売上高647億ドル(同19.8%増)、営業利益40億ドル(黒字転換)と予想します。

インテルのこれまでの業績不振の原因は、新しい生産設備、特にEUV露光装置を使った生産ラインの構築が遅れたことと、先端設備で競争力のある製品を生産できなかったことです。この問題が解消されつつあることで、インテルは次の成長に向かうことが可能になったと思われます。

表8 インテルのセグメント別業績(通期)

出所:会社資料より楽天証券作成

4)今後6~12カ月間の目標株価を65ドルとする。

インテルの今後6~12カ月間の目標株価を65ドルとします。楽天証券の2024年12月期予想EPS0.80ドルに、今後の業績拡大とCPUは揃っているがGPUの品揃えが少ないリスクを考慮し、想定PER80~90倍を当てはめました。

中長期で投資妙味を感じます。

グラフ5 デスクトップPC用CPUの市場シェア

グラフ6 モバイル用CPUの市場シェア

グラフ7 サーバー用CPUの市場シェア

2023年の楽天証券投資WEEKLYは今回が最終です。今年1年間お読みいただき、まことにありがとうございました。

新年は1月5日よりスタート致します。

来年もよろしくお願い致します。よいお年をお迎えください。

本レポートに掲載した銘柄:エヌビディア(NVDA、NASDAQ)、アドバンスト・マイクロ・デバイス(AMD、NASDAQ)、インテル(INTC、NASDAQ)

![[動画で解説]【米国株】NVDA NVDA NVDA 決算からのAI相場](https://m-rakuten.ismcdn.jp/mwimgs/a/9/498m/img_a99e2e3ab1034704f2f060c02adba3aa62018.jpg)

![[動画で解説]【ぽんちよさん】次の目標は3億円!今後も自分の伸びしろに期待【わたしの一番ほしいもの】](https://m-rakuten.ismcdn.jp/mwimgs/a/d/498m/img_ad21cfeab88e1204f91761c115ee74bd50474.jpg)

![[動画で解説]日中首脳会談が開催。習近平政権が石破政権に歩み寄る三つの理由](https://m-rakuten.ismcdn.jp/mwimgs/6/b/498m/img_6b195ba704f93cbaf52c425e486a004045307.jpg)

![[動画で解説]【米国株】NVDA NVDA NVDA 決算からのAI相場](https://m-rakuten.ismcdn.jp/mwimgs/a/9/160m/img_a99e2e3ab1034704f2f060c02adba3aa62018.jpg)

![[動画で解説]【ぽんちよさん】次の目標は3億円!今後も自分の伸びしろに期待【わたしの一番ほしいもの】](https://m-rakuten.ismcdn.jp/mwimgs/a/d/160m/img_ad21cfeab88e1204f91761c115ee74bd50474.jpg)

![[動画で解説]日中首脳会談が開催。習近平政権が石破政権に歩み寄る三つの理由](https://m-rakuten.ismcdn.jp/mwimgs/6/b/160m/img_6b195ba704f93cbaf52c425e486a004045307.jpg)